Nvidia yangi avlod Rubin platformasini taqdim etdi, inferensiya xarajati Blackwell'ga nisbatan 10 baravar arzonlashdi, bu yil ikkinchi yarmida yetkazib berilishi rejalashtirilmoqda

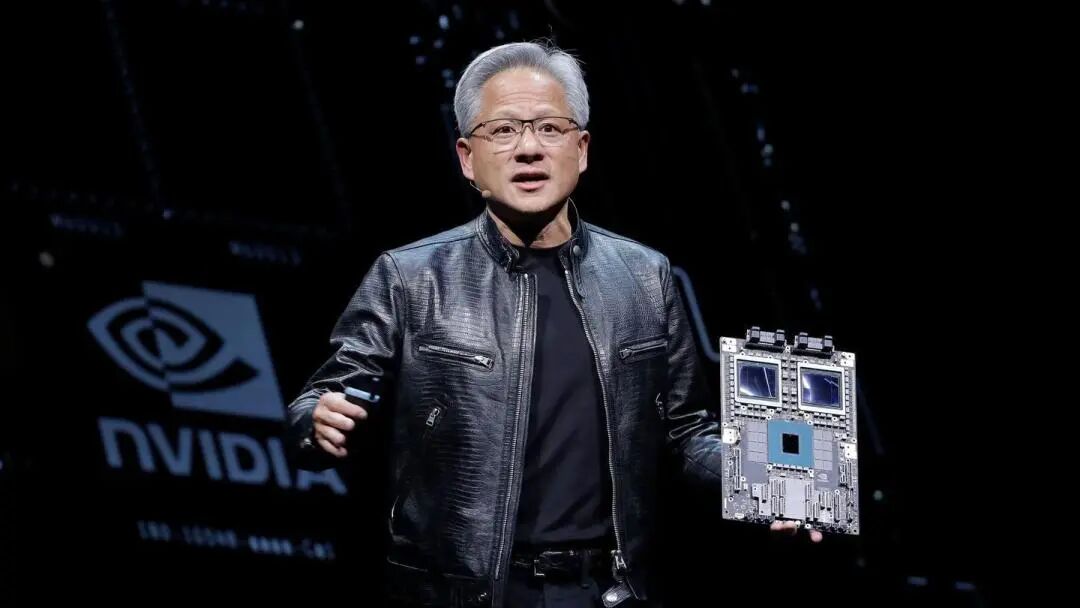

Nvidia CES ko‘rgazmasida yangi avlod Rubin AI platformasini taqdim etdi, bu kompaniyaning sun’iy intellekt (AI) chiplari sohasida har yili yangilanish an’anasini davom ettirishini bildiradi. Ushbu platformaning oltita yangi chipdan iborat integratsiyalashgan dizayni, inferensiya xarajatlari va o‘qitish samaradorligini sezilarli darajada oshirish imkonini beradi va dastlabki mijozlarga 2026 yilning ikkinchi yarmida yetkazib beriladi.

Amerika sharqiy vaqti bilan 5-sentabr, dushanba kuni, Nvidia bosh direktori Huang Renxun Las-Vegasda Rubin chiplarining oltita modeli ishlab chiqaruvchi hamkorlardan qaytib, asosiy testlardan muvaffaqiyatli o‘tganini va reja asosida ish olib borilayotganini ma’lum qildi. U, "AI poygasi boshlandi, hamma navbatdagi darajaga chiqishga harakat qilmoqda", dedi. Nvidia ta’kidlaydi, Rubin asosidagi tizimlarning ishlash xarajati Blackwell versiyasinikidan past bo‘ladi, chunki ular bir xil natijani kamroq komponent bilan ta’minlay oladi.

Microsoft va boshqa yirik bulut hisoblash xizmatlari provayderlari yangi uskunani yilning ikkinchi yarmida birinchi bo‘lib joriy qiladigan mijozlar bo‘ladi. Microsoft’ning navbatdagi Fairwater AI superzavodi Nvidia Vera Rubin NVL72 rack-level tizimi bilan jihozlanadi va bu tizim minglab Nvidia Vera Rubin superchiplarigacha kengaytirilishi mumkin. CoreWeave ham Rubin tizimini taqdim qiluvchi birinchi ta’minotchilardan biri bo‘ladi.

Platformaning taqdim etilishi Wall Street’dagi ayrim shaxslar Nvidia’ning kuchayib borayotgan raqobatga duch kelishi va AI sohasidagi xarajatlar hozirgi tezlikda saqlanib qolishiga shubha qilishayotgan bir paytda sodir bo‘lmoqda. Biroq Nvidia uzoq muddatli optimistik prognozlarni saqlab qolmoqda va umumiy bozor hajmi bir necha trillion dollarga yetishi mumkinligini taxmin qilmoqda.

Yangi avlod AI talablari uchun samaradorlik oshirilmoqda

Nvidia bayonotiga ko‘ra, Rubin platformasining o‘qitish samaradorligi oldingi Blackwell avlodidan 3,5 baravar yuqori, AI dasturlarini ishlatish samaradorligi esa 5 baravar oshirilgan. Blackwell platformasiga nisbatan Rubin inferensiya tokenlarini yaratish xarajatini 10 baravargacha qisqartiradi va aralash ekspertlar modeli (MoE)ni o‘qitishda zarur bo‘lgan GPU soni 4 baravar kamayadi.

Yangi platforma tarkibidagi Vera CPU 88 yadroga ega bo‘lib, uning samaradorligi o‘rnini bosuvchi mahsulotnikidan ikki baravar yuqori. Ushbu CPU maxsus agent inferensiyasi uchun ishlab chiqilgan bo‘lib, keng ko‘lamli AI zavodlaridagi eng energiya samarali protsessordir, 88 ta moslashtirilgan Olympus yadrosi, to‘liq Armv9.2 mosligi va juda tez NVLink-C2C ulanishiga ega.

Rubin GPU’lari uchinchi avlod Transformer dvigateli bilan jihozlangan, apparat tezlashtirilgan moslashuvchan siqish funksiyasiga ega va AI inferensiyasi uchun 50 petaflops NVFP4 hisoblash quvvatini taqdim etadi. Har bir GPU 3,6 TB/s o‘tkazish qobiliyatiga ega, Vera Rubin NVL72 rack esa 260 TB/s o‘tkazish imkonini beradi.

Chiplar sinovi muvaffaqiyatli o‘tmoqda

Huang Renxun barcha oltita Rubin chipi ishlab chiqarish hamkorlaridan qaytarilganini va reja asosida joriy etilishi mumkinligini tasdiqlovchi asosiy testlardan o‘tganini ma’lum qildi. Bu bayonot Nvidia’ning AI akseleratorlarini ishlab chiqarishda yetakchi pozitsiyani saqlayotganini ko‘rsatadi.

Platforma beshta asosiy innovatsion texnologiyani o‘z ichiga oladi: oltinchi avlod NVLink ulanish texnologiyasi, Transformer dvigateli, maxfiy hisoblash, RAS dvigateli va Vera CPU. Uchinchi avlod maxfiy hisoblash texnologiyasi Vera Rubin NVL72 rack’ni birinchi bo‘lib CPU, GPU va NVLink doirasida ma’lumotlarni xavfsiz himoya qiluvchi platformaga aylantiradi.

Ikkinchi avlod RAS dvigateli GPU, CPU va NVLink bo‘ylab real vaqtda sog‘liqni tekshirish, xatolardan himoya va faol xizmat ko‘rsatish imkonini beradi va tizim unumdorligini maksimal darajada oshiradi. Rack modulli, kabelsiz tray dizayniga ega bo‘lib, yig‘ish va xizmat ko‘rsatish Blackwell’dan 18 baravar tez amalga oshiriladi.

Keng ekotizim qo‘llovi

Nvidia ma’lum qilishicha, Amazon AWS, Google Cloud, Microsoft va Oracle Cloud 2026 yilda Vera Rubin asosidagi instansiyalarni birinchi bo‘lib joriy qiladi, bulut hamkorlari CoreWeave, Lambda, Nebius va Nscale ham ortidan boradi.

OpenAI bosh direktori Sam Altman shunday dedi: “Aql kompyuter hisoblash imkoniyati bilan kengayadi. Hisoblash quvvatini oshirsak, modellar kuchayadi, murakkab muammolarni hal qiladi va odamlar uchun ko‘proq foyda keltiradi. Nvidia Rubin platformasi bu rivojlanishni kengaytirishga yordam beradi”.

Anthropic hammuassisi va bosh direktori Dario Amodei, Nvidia “Rubin platformasining samaradorlik oshishi — bu uzoqroq xotira, yaxshiroq inferensiya va ishonchliroq natijalarni ta’minlaydigan infratuzilma taraqqiyotidir”, deb baholadi.

Meta bosh direktori Mark Zuckerberg ta’kidlashicha, Nvidia’ning “Rubin platformasi samaradorlik va unumdorlikda sakrashli o‘zgarishlar olib keladi, bu esa ilg‘or modellarni milliardlab odamlarga taqdim etish uchun zarur” dedi.

Nvidia shuningdek, Cisco, Dell, Hewlett Packard Enterprise, Lenovo va Supermicro Rubin mahsulotlari asosidagi serverlar turini taqdim etishi kutilmoqda. Anthropic, Cohere, Meta, Mistral AI, OpenAI va xAI kabi AI laboratoriyalari Rubin platformasidan yanada kattaroq va kuchli modellarni o‘qitishda foydalanishni intiqlik bilan kutmoqda.

Mahsulot tafsilotlari oldindan e’lon qilindi

Izohlanishicha, Nvidia bu yil avvalgidan ham oldinroq yangi mahsulot tafsilotlarini e’lon qilmoqda, bu kompaniyaning soha o‘z apparatlariga tayanishini ta’minlashga intilishidir. Chunki Nvidia odatda har yili bahorda Kaliforniya shtatining San-Xose shahrida o‘tkaziladigan GTC tadbirida mahsulot tafsilotlarini chuqurroq ochib beradi.

Huang Renxun uchun CES — bu marafon tarzidagi tadbirlarda ishtirok etishining yana bir bosqichi, u har xil tadbirlarda mahsulotlar, hamkorlik va investitsiyalar haqida e’lon qilishi, bularning barchasi AI tizimlarini joriy qilishni tezlashtirishga qaratilgan.

Nvidia e’lon qilgan yangi apparatlar tarkibiga tarmoq va ulanish komponentlari ham kiradi, ular DGX SuperPod superkompyuterining bir qismi bo‘ladi, shuningdek, mijozlar uchun mustaqil mahsulot sifatida modul tarzda ishlatilishi mumkin. Ushbu samaradorlik oshishi zarur, chunki AI endi nafaqat ulkan kirish ma’lumotlarini saralovchi, balki ko‘p bosqichli jarayonlarda aniq muammolarni hal qiladigan ixtisoslashtirilgan model tarmoqlari tomon rivojlanmoqda.

Nvidia butun iqtisodiyotda AI ilovalarini joriy qilishni kuchaytirmoqda, jumladan robototexnika, sog‘liqni saqlash va og‘ir sanoat sohalarida. Ushbu harakat doirasida Nvidia avtonom avtomobillar va robotlarni ishlab chiqishni jadallashtirishga qaratilgan bir qator vositalarni taqdim etdi. Hozirda Nvidia asosidagi kompyuter xarajatlarining asosiy qismini Microsoft, Alphabet tarkibidagi Google Cloud va Amazon’ning AWS kabi yirik mijozlarning kapital xarajatlari tashkil etadi.

Mas'uliyatni rad etish: Ushbu maqolaning mazmuni faqat muallifning fikrini aks ettiradi va platformani hech qanday sifatda ifodalamaydi. Ushbu maqola investitsiya qarorlarini qabul qilish uchun ma'lumotnoma sifatida xizmat qilish uchun mo'ljallanmagan.

Sizga ham yoqishi mumkin

JPY 2025-yilni Dollar ga nisbatan biroz kuchliroq yakunlaydi – Commerzbank

AUD/USD bugungi orqaga chekinishdan keyin ham yuqoriga harakatni saqlab turibdi – Rabobank

Kripto likvidatsiyalari $477 milliondan oshdi, Bitcoin $90K pastiga tushdi

Shell neft savdosida sust natijalarni hisobot qiladi