Czy wojna DA dobiega końca? Analiza PeerDAS – jak może pomóc Ethereum odzyskać ��„suwerenność danych”

Autor: imToken

Pod koniec 2025 roku społeczność Ethereum stosunkowo spokojnie przyjęła zakończenie aktualizacji Fusaka.

Patrząc wstecz na ostatni rok, chociaż dyskusje na temat aktualizacji technologii bazowej stopniowo zeszły z pierwszego planu rynku, wielu użytkowników on-chain z pewnością już odczuło znaczącą zmianę: Ethereum L2 staje się coraz tańsze.

Obecnie interakcje on-chain, niezależnie czy to transfery czy złożone operacje DeFi, wymagają opłat za Gas często jedynie kilku centów lub wręcz pomijalnych. Za tym sukcesem stoją aktualizacja Dencun i mechanizm Blob, a jednocześnie, wraz z oficjalnym uruchomieniem kluczowej funkcji PeerDAS (Peer Data Availability Sampling, czyli rozproszona weryfikacja dostępności danych) w aktualizacji Fusaka, Ethereum definitywnie żegna się z erą weryfikacji danych poprzez „pełne pobieranie”.

Można powiedzieć, że to nie sam Blob, lecz kolejny krok reprezentowany przez PeerDAS, naprawdę zdecyduje, czy Ethereum będzie w stanie długoterminowo i zrównoważenie obsługiwać aplikacje na dużą skalę.

I. Czym jest PeerDAS?

Aby zrozumieć rewolucyjne znaczenie PeerDAS, nie możemy mówić tylko o koncepcjach, musimy najpierw wrócić do kluczowego momentu na drodze skalowania Ethereum, czyli do aktualizacji Dencun z marca 2024 roku.

Wtedy EIP-4844, wprowadzając model transakcji z Blob (osadzając dużą ilość danych transakcyjnych w blobie), umożliwił L2 odejście od kosztownego mechanizmu przechowywania calldata na rzecz tymczasowego przechowywania w Blob.

Ta zmiana bezpośrednio obniżyła koszty Rollup do jednej dziesiątej wcześniejszego poziomu, zapewniając, że platformy L2 mogą oferować tańsze i szybsze transakcje bez wpływu na bezpieczeństwo i decentralizację opartą na Ethereum, a użytkownicy mogli poczuć „erę niskich opłat za Gas”.

Jednak mimo że Blob jest bardzo użyteczny, liczba Blobów, które mogą być zawarte w każdym bloku głównej sieci Ethereum, ma twardy limit (zwykle 3-6), z bardzo praktycznego powodu: fizyczna przepustowość i pojemność dysków są ograniczone.

W tradycyjnym modelu weryfikacji każdy walidator w sieci, niezależnie czy to serwer prowadzony przez profesjonalną instytucję, czy zwykły komputer w domu inwestora detalicznego, nadal musi pobrać i rozesłać pełne dane Blob, aby potwierdzić ich ważność.

To prowadzi do dylematu:

- Jeśli zwiększymy liczbę Blobów (dla skalowania): ilość danych gwałtownie wzrośnie, przepustowość domowych węzłów zostanie wyczerpana, dyski się zapełnią, co zmusi je do wyłączenia się z sieci, a sieć szybko się scentralizuje, stając się łańcuchem obsługiwanym tylko przez wielkie centra danych;

- Jeśli ograniczymy liczbę Blobów (dla decentralizacji): przepustowość L2 zostanie zablokowana i nie będzie w stanie sprostać przyszłemu gwałtownemu wzrostowi zapotrzebowania.

Krótko mówiąc, Blob to dopiero pierwszy krok, rozwiązujący problem „gdzie przechowywać” dane. Gdy danych jest mało, wszystko działa dobrze, ale jeśli w przyszłości liczba Rollup będzie nadal rosnąć, każdy Rollup będzie często przesyłał dane, a pojemność Blob będzie się stale zwiększać, wtedy przepustowość i pojemność dysków węzłów staną się nowym ryzykiem centralizacji.

Jeśli nadal będziemy korzystać z tradycyjnego modelu pełnego pobierania, nie rozwiążemy problemu przepustowości, a droga do skalowania Ethereum rozbije się o ścianę fizycznych ograniczeń, natomiast PeerDAS jest kluczem do rozwiązania tego problemu.

W skrócie, PeerDAS to zupełnie nowa architektura weryfikacji danych, która łamie żelazną zasadę, że weryfikacja wymaga pełnego pobrania, pozwalając na skalowanie Blobów poza obecny poziom fizycznej przepustowości (np. z 6 Blobów/blok do 48 lub więcej).

II. Blob rozwiązuje „gdzie przechowywać”, PeerDAS rozwiązuje „jak przechowywać”

Jak wspomniano wyżej, Blob to pierwszy krok w skalowaniu, rozwiązujący problem „gdzie przechowywać” dane (z kosztownego Calldata do tymczasowej przestrzeni Blob), natomiast PeerDAS ma rozwiązać problem „jak przechowywać wydajniej”.

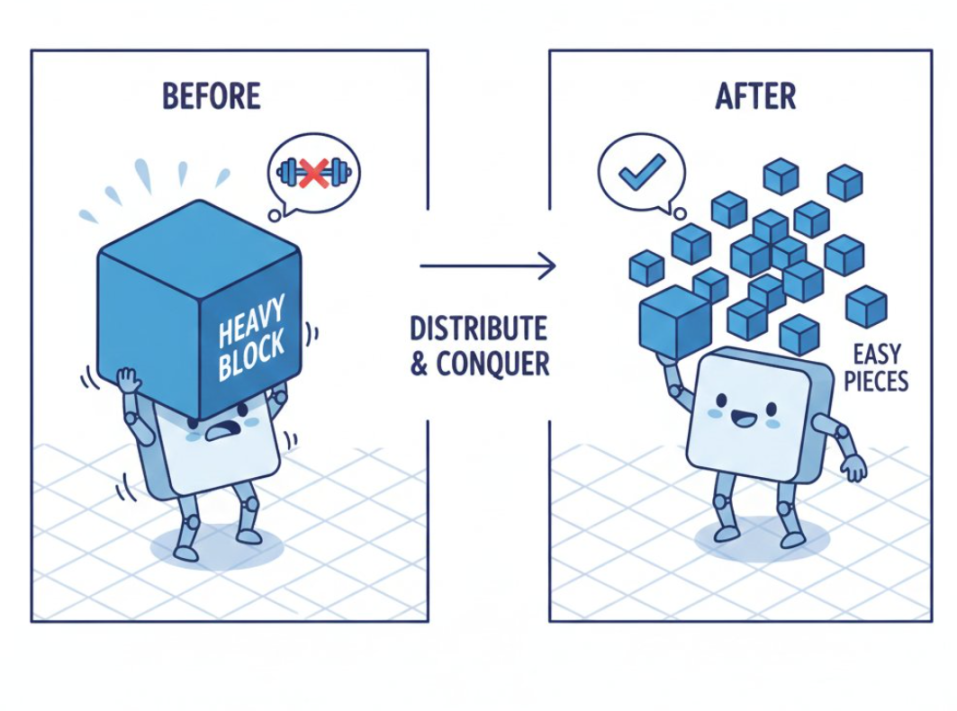

Jego głównym celem jest umożliwienie wykładniczego wzrostu ilości danych bez przeciążania fizycznej przepustowości węzłów. Rozwiązanie jest proste: dzięki probabilistycznej i rozproszonej współpracy „nie każdy musi przechowywać pełne dane, a mimo to z dużym prawdopodobieństwem można potwierdzić ich istnienie”.

Już sama pełna nazwa PeerDAS – „rozproszona weryfikacja dostępności danych” – sugeruje to podejście.

Choć brzmi to skomplikowanie, można to wyjaśnić prostą analogią: tradycyjna pełna weryfikacja przypomina sytuację, gdy biblioteka otrzymuje kilkutysięczną „Encyklopedię Brytyjską” (dane Blob) i aby zapobiec utracie, każdy bibliotekarz (węzeł) musi zrobić pełną kopię książki jako zapas.

To oznacza, że tylko osoby z dużymi zasobami (przepustowość/dysk) mogą być bibliotekarzami, a ponieważ „Encyklopedia Brytyjska” (dane Blob) stale rośnie, z czasem zwykli ludzie zostaną wykluczeni, a decentralizacja zniknie.

Teraz jednak, dzięki próbkowaniu PeerDAS i technikom takim jak kodowanie z usuwaniem (Erasure Coding), książkę można podzielić na niezliczone fragmenty i matematycznie zakodować. Każdy bibliotekarz nie musi już przechowywać całej książki, wystarczy, że losowo wybierze kilka stron i je zachowa.

Nawet podczas weryfikacji nikt nie musi przedstawiać całej książki – teoretycznie, jeśli cała sieć zgromadzi dowolne 50% fragmentów (niezależnie czy ktoś ma stronę 10 czy 100), można natychmiast matematycznie odtworzyć całą książkę z 100% pewnością.

To właśnie magia PeerDAS – zdejmuje ciężar pobierania danych z pojedynczego węzła i rozkłada go na tysiące węzłów współpracujących w całej sieci.

Źródło: @Maaztwts

Źródło: @Maaztwts

Patrząc tylko na dane, przed aktualizacją Fusaka liczba Blobów była ściśle ograniczona do kilku (3-6). Wdrożenie PeerDAS bezpośrednio zniosło ten limit, pozwalając na wzrost liczby Blobów z 6 do 48, a nawet więcej.

Kiedy użytkownik wykonuje transakcję na Arbitrum lub Optimism, a dane są pakowane i przesyłane do głównej sieci, nie trzeba już rozsyłać pełnego pakietu danych po całej sieci, co pozwala Ethereum na skalowanie bez liniowego wzrostu kosztów węzłów.

Obiektywnie rzecz biorąc, Blob + PeerDAS to pełne rozwiązanie DA (dostępności danych), a z perspektywy roadmapy jest to kluczowy etap przejścia Ethereum od Proto-Danksharding do pełnego Danksharding.

III. Nowa norma on-chain w erze po Fusaka

Jak wiadomo, w ostatnich dwóch latach takie warstwy DA jak Celestia zyskały ogromny udział w rynku dzięki wysokim kosztom przechowywania danych na głównej sieci Ethereum. Ich narracja opierała się na założeniu, że natywne przechowywanie danych na Ethereum jest bardzo drogie.

Jednak dzięki Blob i najnowszemu PeerDAS, Ethereum stało się zarówno tanie, jak i niezwykle bezpieczne: koszt publikowania danych z L2 do L1 został drastycznie obniżony, a Ethereum posiada największą na świecie sieć walidatorów, co zapewnia bezpieczeństwo znacznie przewyższające łańcuchy trzecie.

Obiektywnie rzecz biorąc, dla rozwiązań DA takich jak Celestia to prawdziwy cios, oznaczający, że Ethereum odzyskuje suwerenność nad dostępnością danych i znacząco ogranicza ich przestrzeń rynkową.

Możesz zapytać: to wszystko brzmi bardzo technicznie, ale jaki to ma związek z moim portfelem, przelewami czy DeFi?

Związek jest bardzo bezpośredni. Jeśli PeerDAS zostanie pomyślnie wdrożony, oznacza to, że koszty danych L2 mogą pozostać niskie przez długi czas, Rollupy nie będą musiały podnosić opłat z powodu wzrostu kosztów DA, aplikacje on-chain będą mogły swobodnie projektować interakcje o wysokiej częstotliwości, a portfele i DAppy nie będą musiały ciągle wybierać między „funkcjonalnością a kosztami”....

Innymi słowy, to dzięki Blob możemy dziś korzystać z tanich L2, a jeśli w przyszłości nadal będzie nas na nie stać, to będzie zasługa cichego wkładu PeerDAS.

Dlatego właśnie PeerDAS, choć niepozorny, jest nieodzownym etapem na roadmapie skalowania Ethereum. W istocie, to najlepsza forma technologii w oczach autora – „korzystasz, nie zauważając, a gdy jej zabraknie, trudno się obyć”, sprawiając, że jej obecność jest niewidoczna.

Ostatecznie PeerDAS udowadnia, że blockchain dzięki wyrafinowanym rozwiązaniom matematycznym (takim jak próbkowanie danych) może obsługiwać ogromne ilości danych na poziomie Web2 bez nadmiernego poświęcania wizji decentralizacji.

W ten sposób autostrada danych Ethereum została już całkowicie zbudowana – teraz to warstwa aplikacji musi odpowiedzieć, jakie „samochody” po niej pojadą.

Poczekajmy i zobaczmy.

Zastrzeżenie: Treść tego artykułu odzwierciedla wyłącznie opinię autora i nie reprezentuje platformy w żadnym charakterze. Niniejszy artykuł nie ma służyć jako punkt odniesienia przy podejmowaniu decyzji inwestycyjnych.

Może Ci się również spodobać

Radykalny zakład Samsona Mowa na Bitcoin: Porzucenie wszystkiego dla BTC

Instytucje zwiększają akumulację Ethereum; podaż na giełdach pozostaje znacząca

Gubernator Kalifornii krytykuje ułaskawienia kryptowalutowe Trumpa