Co się stało z ponownym stakingiem?

Dogłębna analiza drogi ponownego stakowania EigenLayer: napotkane trudności i sukcesy EigenDA, które torują drogę dla nowego kierunku EigenCloud.

Dogłębna analiza drogi EigenLayer w zakresie restakingu: napotkane pułapki, sukces EigenDA – wszystko to przygotowało grunt pod nowy kierunek EigenCloud.

Autor: Kydo, szef narracji EigenCloud

Tłumaczenie: Saoirse, Foresight News

Od czasu do czasu znajomi przesyłają mi ironiczne tweety na temat restakingu, ale żaden z nich nie trafia w sedno sprawy. Dlatego postanowiłem sam napisać tekst o charakterze refleksyjnym – „narzekanie z przemyśleniami”.

Możesz uważać, że jestem zbyt blisko tej sprawy, by zachować obiektywizm; albo że jestem zbyt dumny, by przyznać się do „pomyłki”. Możesz sądzić, że nawet jeśli wszyscy uznali już „porażkę restakingu”, ja i tak napiszę długi tekst na obronę, nie chcąc użyć słowa „porażka”.

Te opinie są uzasadnione i wiele z nich ma sens.

Jednak ten artykuł ma na celu jedynie obiektywne przedstawienie faktów: co się wydarzyło, co się udało, co się nie powiodło i jakich lekcji się nauczyliśmy.

Mam nadzieję, że doświadczenia opisane w tekście będą uniwersalne i staną się wskazówką dla deweloperów z innych ekosystemów.

Po ponad dwóch latach integracji wszystkich głównych AVS (Autonomous Validation Services) na EigenLayer i projektowania EigenCloud, chcę szczerze podsumować: gdzie popełniliśmy błędy, co zrobiliśmy dobrze i dokąd zmierzamy.

Czym właściwie jest restaking?

To, że wciąż muszę tłumaczyć „czym jest restaking”, samo w sobie pokazuje, że gdy restaking był na ustach branży, nie potrafiliśmy go jasno wyjaśnić. To „lekcja numer 0” – skup się na jednym kluczowym przekazie i powtarzaj go wielokrotnie.

Celem zespołu Eigen zawsze było „łatwo powiedzieć, trudno zrobić”: poprzez zwiększenie weryfikowalności obliczeń off-chain umożliwić ludziom bezpieczniejsze budowanie aplikacji on-chain.

AVS to nasza pierwsza i wyraźnie określona próba w tym kierunku.

AVS (Autonomous Validation Services) to sieć proof-of-stake (PoS), w której zdecentralizowani operatorzy wykonują zadania off-chain. Ich działania są monitorowane, a w przypadku naruszeń stawka zostaje ukarana. Aby taki mechanizm kary działał, musi istnieć „kapitał stakingowy” jako zabezpieczenie.

To właśnie tutaj leży wartość restakingu: bez konieczności budowania od zera systemu bezpieczeństwa dla każdego AVS, restaking pozwala na ponowne wykorzystanie już stakowanych ETH, zapewniając bezpieczeństwo wielu AVS. To nie tylko obniża koszty kapitałowe, ale także przyspiesza rozwój ekosystemu.

Tak więc ramy koncepcyjne restakingu można podsumować następująco:

- AVS: czyli „warstwa usług”, stanowiąca podstawę nowego typu systemów bezpieczeństwa PoS w kryptoekonomii;

- Restaking: czyli „warstwa kapitałowa”, która poprzez ponowne wykorzystanie istniejących aktywów stakingowych zapewnia tym systemom bezpieczeństwo.

Nadal uważam, że to bardzo sprytna koncepcja, ale rzeczywistość nie była tak idealna jak na diagramach – wiele rzeczy nie spełniło oczekiwań.

Rzeczy, które nie spełniły oczekiwań

1. Wybraliśmy zły rynek: zbyt niszowy

Nie chcieliśmy „jakiejkolwiek weryfikowalnej kalkulacji”, lecz uparcie dążyliśmy do systemów, które od pierwszego dnia są zdecentralizowane, oparte na mechanizmach kary i w pełni zabezpieczone kryptoekonomicznie.

Chcieliśmy, by AVS stały się „usługami infrastrukturalnymi” – tak jak deweloperzy mogą budować SaaS (Software as a Service), każdy mógłby tworzyć AVS.

To podejście, choć zasadnicze, bardzo zawęziło grono potencjalnych deweloperów.

W efekcie rynek, z którym się mierzyliśmy, był „mały, rozwijał się wolno i miał wysokie bariery wejścia”: niewielu potencjalnych użytkowników, wysokie koszty wdrożenia, długie cykle po obu stronach (zespołu i deweloperów). Zarówno infrastruktura EigenLayer, narzędzia deweloperskie, jak i każdy AVS na wyższym poziomie wymagały miesięcy, a nawet lat, by powstać.

Po prawie trzech latach: obecnie mamy tylko dwa główne AVS działające w środowisku produkcyjnym – Infura’s DIN (Decentralized Infrastructure Network) i LayerZero’s EigenZero. Taka „adopcja” nie jest „szeroka”.

Szczerze mówiąc, nasz pierwotny scenariusz zakładał, że zespoły będą chciały od pierwszego dnia mieć kryptoekonomiczne bezpieczeństwo i zdecentralizowanych operatorów, ale rzeczywiste potrzeby rynku były „bardziej stopniowe i skoncentrowane na aplikacjach”.

2. Ograniczeni przez otoczenie regulacyjne, byliśmy zmuszeni do „milczenia”

Gdy uruchamialiśmy projekt, trwał szczyt „ery Gary’ego Genslera” (przyp. red.: Gary Gensler to przewodniczący SEC w USA, znany z surowego podejścia do branży krypto). W tym czasie wiele firm stakingowych było przedmiotem dochodzeń i pozwów.

Jako „projekt restakingowy”, niemal każde nasze publiczne słowo mogło zostać zinterpretowane jako „obietnica inwestycyjna”, „reklama zysków”, a nawet sprowadzić na nas wezwanie sądowe.

Ta mgła regulacyjna zdeterminowała nasz sposób komunikacji: nie mogliśmy swobodnie się wypowiadać, nawet gdy zalewały nas negatywne artykuły, partnerzy zrzucali na nas winę, a my byliśmy atakowani przez opinię publiczną – nie mogliśmy na bieżąco wyjaśniać nieporozumień.

Nawet zwykłe „to nie tak” wymagało rozważenia ryzyka prawnego.

W efekcie, przy braku odpowiedniej komunikacji, wypuściliśmy token z blokadą. Patrząc wstecz, to było ryzykowne.

Jeśli kiedykolwiek miałeś wrażenie, że „zespół Eigen unika tematu lub jest wyjątkowo milczący”, to prawdopodobnie wynikało to z takiego otoczenia regulacyjnego – jeden błędny tweet mógł nieść poważne konsekwencje.

3. Wczesne AVS rozmyły wartość marki

Wczesny wpływ marki Eigen w dużej mierze wynikał z Sreerama (kluczowego członka zespołu) – jego energia, optymizm i wiara, że zarówno system, jak i ludzie mogą być lepsi, przyniosły zespołowi wiele sympatii.

Dziesiątki miliardów kapitału stakingowego jeszcze bardziej wzmocniły to zaufanie.

Jednak nasza wspólna promocja pierwszych AVS nie dorównała tej „wysokości marki”. Wiele wczesnych AVS było głośnych, ale podążały jedynie za trendami branżowymi – nie były ani „najlepsze technologicznie”, ani „najbardziej godne zaufania” jako przykłady AVS.

Z czasem ludzie zaczęli kojarzyć „EigenLayer” z „najnowszym yield farmingiem, airdropami”. Dzisiejsze wątpliwości, zmęczenie, a nawet niechęć, mają swoje korzenie w tym okresie.

Gdybym mógł to powtórzyć, zacząłbym od „mniejszej liczby, ale lepszych AVS”, byłbym bardziej wybredny w doborze partnerów do sygnowania marką i zaakceptowałbym „wolniejsze tempo, mniejsze zainteresowanie” w promocji.

4. Nadmierne dążenie do „minimalizacji zaufania” doprowadziło do nadmiarowości w projektowaniu

Próbowaliśmy zbudować „idealny uniwersalny system kar”, który miał być uniwersalny, elastyczny i obejmować wszystkie scenariusze kar, by osiągnąć „minimalizację zaufania”.

W praktyce spowodowało to powolne iteracje produktu i konieczność poświęcania mnóstwa czasu na tłumaczenie mechanizmu, którego „większość ludzi nie była jeszcze gotowa zrozumieć”. Nawet dziś, prawie rok po wprowadzeniu systemu kar, wciąż musimy go tłumaczyć.

Patrząc wstecz, rozsądniej byłoby najpierw wypuścić prosty system kar, pozwolić AVS testować bardziej skoncentrowane modele, a dopiero potem stopniowo zwiększać złożoność systemu. My jednak zaczęliśmy od „skomplikowanego projektu”, za co zapłaciliśmy cenę w postaci „wolniejszego tempa” i „mniejszej przejrzystości”.

Co naprawdę się udało

Ludzie często zbyt pochopnie przyklejają etykietę „porażki” – to zbyt powierzchowne podejście.

W rozdziale „restaking” wiele rzeczy poszło naprawdę dobrze, a te osiągnięcia są kluczowe dla naszego przyszłego kierunku.

1. Udowodniliśmy, że potrafimy wygrywać na konkurencyjnym rynku

Wolimy „win-win”, ale nie boimy się konkurencji – jeśli wchodzimy na jakiś rynek, musimy być liderem.

W dziedzinie restakingu Paradigm i Lido wspierały naszego bezpośredniego konkurenta. Wtedy wartość TVL EigenLayer nie przekraczała 1.1 billions.

Konkurenci mieli przewagę narracyjną, kanały, wsparcie kapitałowe i „domyślne zaufanie”. Wielu mówiło mi: „ich zespół będzie miał większą skuteczność i was zmiażdży”. Rzeczywistość była inna – dziś mamy 95% udziału w rynku kapitału restakingowego i przyciągnęliśmy 100% czołowych deweloperów.

W obszarze „data availability (DA)” zaczynaliśmy później, z mniejszym zespołem i mniejszymi środkami, a liderzy rynku mieli przewagę pierwszeństwa i silny marketing. Dziś, według wszystkich kluczowych wskaźników, EigenDA (rozwiązanie DA od Eigen) zajmuje znaczną część rynku DA; wraz z pełnym wdrożeniem największych partnerów ten udział będzie rósł wykładniczo.

Oba te rynki były bardzo konkurencyjne, ale udało nam się sięgnąć po zwycięstwo.

2. EigenDA stało się dojrzałym produktem „zmieniającym ekosystem”

Wprowadzenie EigenDA na infrastrukturze EigenLayer było ogromnym zaskoczeniem.

Stało się ono fundamentem EigenCloud i przyniosło Ethereum coś bardzo potrzebnego – ogromny kanał DA. Dzięki temu rollupy mogą działać z dużą prędkością, nie musząc opuszczać ekosystemu Ethereum na rzecz innych nowych blockchainów.

MegaETH wystartowało, bo zespół wierzył, że Sreeram pomoże im przełamać wąskie gardło DA; Mantle zaproponowało BitDAO budowę L2 z tego samego powodu.

EigenDA stało się też „tarczą obronną” Ethereum: gdy ekosystem ma natywne, wysokoprzepustowe rozwiązanie DA, zewnętrznym blockchainom trudniej „przyciągać uwagę narracją Ethereum i wysysać wartość ekosystemu”.

3. Wspieranie rozwoju rynku pre-confirmation

Jednym z kluczowych tematów EigenLayer na początku było, jak odblokować funkcję pre-confirmation w Ethereum przez EigenLayer.

Od tego czasu pre-confirmation zyskało dużą uwagę dzięki sieci Base, ale wdrożenie wciąż jest wyzwaniem.

Aby wspierać rozwój ekosystemu, współtworzyliśmy program Commit-Boost – mający rozwiązać „efekt blokady” klientów pre-confirmation i stworzyć neutralną platformę, na której każdy może innowować poprzez zobowiązania walidatorów.

Obecnie przez Commit-Boost przepływają miliardy dolarów, a ponad 35% walidatorów już dołączyło do programu. Wraz z uruchomieniem głównych usług pre-confirmation w najbliższych miesiącach ten odsetek jeszcze wzrośnie.

To kluczowe dla „antykruchości” ekosystemu Ethereum i stanowi fundament dalszych innowacji na rynku pre-confirmation.

4. Zawsze zapewnialiśmy bezpieczeństwo aktywów

Przez lata zapewnialiśmy bezpieczeństwo aktywów o wartości setek miliardów dolarów.

To brzmi zwyczajnie, wręcz „nudno” – ale wystarczy pomyśleć, ile infrastruktur w branży krypto „zawaliło się” na różne sposoby, by docenić tę „zwyczajność”. By zminimalizować ryzyko, zbudowaliśmy solidny system bezpieczeństwa operacyjnego, zatrudniliśmy i wyszkoliliśmy światowej klasy zespół ds. bezpieczeństwa oraz wprowadziliśmy „myślenie antagonistyczne” do kultury zespołu.

Taka kultura jest kluczowa dla każdego biznesu związanego z funduszami użytkowników, AI lub systemami rzeczywistymi i „nie da się jej nadrobić później” – fundamenty trzeba budować od początku.

5. Powstrzymaliśmy Lido przed długoterminowym przekroczeniem 33% udziału w stakingu

Era restakingu miała niedoceniany wpływ: ogromna ilość ETH trafiła do dostawców LRT, co zapobiegło długotrwałemu przekroczeniu przez Lido 33% udziału w stakingu.

To ma ogromne znaczenie dla „społecznej równowagi” Ethereum. Gdyby Lido przez długi czas miało ponad 33% udziału bez alternatyw, wywołałoby to poważne kontrowersje i konflikty wewnętrzne.

Restaking i LRT nie „magicznie zdecentralizowały” stakingu, ale zmieniły trend koncentracji – to nie jest małe osiągnięcie.

6. Wyznaczyliśmy, gdzie leży „prawdziwa awangarda”

Największym „zyskiem” była zmiana podejścia: potwierdziliśmy kluczową tezę, że „świat potrzebuje więcej systemów weryfikowalnych”, ale też zrozumieliśmy, jak to osiągnąć – poprzedni kierunek był błędny.

Właściwa droga to nie „zaczynać od ogólnego bezpieczeństwa kryptoekonomicznego, od razu budować w pełni zdecentralizowany system operatorów i czekać, aż wszystkie biznesy dołączą do tej warstwy”.

Prawdziwy sposób na przyspieszenie „awangardy” to: dać deweloperom bezpośrednie narzędzia, by mogli zapewnić weryfikowalność dla swoich aplikacji i dopasować do nich odpowiednie prymitywy walidacyjne. Musimy „aktywnie zbliżać się do potrzeb deweloperów”, a nie wymagać, by od pierwszego dnia byli „projektantami protokołów”.

W tym celu zaczęliśmy budować wewnętrzne usługi modułowe – EigenCompute (usługa weryfikowalnych obliczeń) i EigenAI (usługa weryfikowalnej AI). Niektóre funkcje, na które inne zespoły muszą zebrać setki milionów dolarów i pracować latami, my wdrażamy w kilka miesięcy.

Kolejne kroki

Jak więc zareagować na te doświadczenia – wyczucie czasu, sukcesy, porażki, „blizny” marki?

Oto krótko nasze plany na przyszłość i stojąca za nimi logika:

1. Uczynić token EIGEN rdzeniem systemu

W przyszłości cały EigenCloud i wszystkie produkty wokół niego będą skoncentrowane wokół tokena EIGEN.

Rola tokena EIGEN to:

- główny napęd bezpieczeństwa ekonomicznego EigenCloud;

- aktywo zabezpieczające różne rodzaje ryzyka platformy;

- kluczowe narzędzie przechwytywania wartości wszystkich przepływów opłat i aktywności ekonomicznej na platformie.

Wcześniej wielu miało oczekiwania wobec „wartości, jaką może przechwycić token EIGEN”, które nie pokrywały się z „rzeczywistym mechanizmem” – to powodowało zamieszanie. W kolejnym etapie wypełnimy tę lukę poprzez konkretne projekty i wdrożenia. Więcej szczegółów wkrótce.

2. Pozwolić deweloperom budować „weryfikowalne aplikacje”, nie tylko AVS

Nasza kluczowa teza się nie zmienia: poprzez zwiększenie weryfikowalności obliczeń off-chain umożliwić ludziom bezpieczniejsze budowanie aplikacji on-chain. Ale narzędzia do osiągnięcia „weryfikowalności” nie będą już ograniczone do jednego typu.

Czasem będzie to bezpieczeństwo kryptoekonomiczne; czasem ZK proof, TEE (Trusted Execution Environment) lub rozwiązania hybrydowe. Klucz nie leży w „promowaniu jednej technologii”, lecz w tym, by „weryfikowalność” stała się standardowym prymitywem dostępnym w stacku technologicznym dewelopera.

Naszym celem jest zmniejszenie dystansu między „mam aplikację” a „mam aplikację, którą mogą zweryfikować użytkownicy, partnerzy i regulatorzy”.

Patrząc na obecny stan branży, „kryptoekonomia + TEE” to bez wątpienia najlepszy wybór – zapewnia optymalną równowagę między „programowalnością” (co deweloper może zbudować) a „bezpieczeństwem” (nie teoretycznym, lecz rzeczywistym, wdrażalnym).

W przyszłości, gdy ZK proof i inne mechanizmy walidacji będą wystarczająco dojrzałe i spełnią potrzeby deweloperów, zintegrujemy je z EigenCloud.

3. Głębokie wejście w AI

Największa rewolucja w globalnej branży obliczeniowej to AI – zwłaszcza AI Agents. Branża krypto nie może pozostać na uboczu.

AI Agents to w istocie „modele językowe otoczone narzędziami, wykonujące operacje w określonym środowisku”.

Obecnie nie tylko modele językowe są „czarną skrzynką”, ale także logika działania AI Agents jest nieprzejrzysta – dlatego już pojawiły się ataki hakerskie wynikające z „konieczności zaufania deweloperowi”.

Jeśli jednak AI Agents będą „weryfikowalne”, nie będzie już potrzeby polegać na zaufaniu do dewelopera.

Aby osiągnąć weryfikowalność AI Agents, trzeba spełnić trzy warunki: weryfikowalność procesu inferencji LLM (Large Language Model), weryfikowalność środowiska wykonawczego oraz weryfikowalność warstwy danych do przechowywania, wyszukiwania i rozumienia kontekstu.

EigenCloud został zaprojektowany właśnie dla takich scenariuszy:

- EigenAI: zapewnia deterministyczną, weryfikowalną usługę inferencji LLM;

- EigenCompute: zapewnia weryfikowalne środowisko wykonawcze;

- EigenDA: zapewnia weryfikowalne przechowywanie i wyszukiwanie danych.

Wierzymy, że „weryfikowalne AI Agents” to jeden z najbardziej konkurencyjnych przypadków użycia naszych „weryfikowalnych usług chmurowych” – dlatego powołaliśmy dedykowany zespół do pracy w tym obszarze.

4. Przedefiniowanie narracji „stakingu i zysków”

Aby uzyskać realne zyski, trzeba podjąć realne ryzyko.

Badamy szersze „zastosowania stakingu”, by kapitał stakingowy mógł zabezpieczać następujące ryzyka:

- ryzyko smart kontraktów;

- ryzyko różnych typów obliczeń;

- ryzyko, które można jasno opisać i wycenić.

Przyszłe zyski będą rzeczywistym odzwierciedleniem „przejrzystego, zrozumiałego ryzyka”, a nie tylko pogoń za „modą na yield farming”.

Ta logika naturalnie przeniknie do zastosowań, zakresu zabezpieczeń i mechanizmów wartości tokena EIGEN.

Na zakończenie

Restaking nie stał się „warstwą uniwersalną”, na którą liczyłem (i inni również), ale też nie zniknął. W długim procesie rozwoju stał się tym, czym staje się większość „pierwszych produktów”:

Ważnym rozdziałem, zbiorem cennych lekcji i infrastrukturą wspierającą dziś szerszy biznes.

Nadal utrzymujemy działalność związaną z restakingiem i wciąż ją cenimy – po prostu nie chcemy być już ograniczani pierwotną narracją.

Jeśli jesteś członkiem społeczności, deweloperem AVS lub inwestorem, który wciąż kojarzy Eigen z „tym projektem restakingowym”, mam nadzieję, że ten tekst pozwoli ci lepiej zrozumieć „co się wydarzyło” i „gdzie teraz zmierzamy”.

Wkraczamy dziś w obszar o „większym Total Addressable Market (TAM)”: z jednej strony usługi chmurowe, z drugiej – bezpośrednie potrzeby aplikacyjne deweloperów. Nadal eksplorujemy „niewykorzystaną ścieżkę AI” i będziemy realizować te kierunki z naszą charakterystyczną skutecznością.

Zespół wciąż jest pełen energii, a ja nie mogę się doczekać, by udowodnić wszystkim sceptykom – damy radę.

Nigdy nie byłem tak optymistycznie nastawiony do Eigen jak teraz i stale zwiększam swoje zasoby tokenów EIGEN – zamierzam to kontynuować.

Wciąż jesteśmy na początku drogi.

Zastrzeżenie: Treść tego artykułu odzwierciedla wyłącznie opinię autora i nie reprezentuje platformy w żadnym charakterze. Niniejszy artykuł nie ma służyć jako punkt odniesienia przy podejmowaniu decyzji inwestycyjnych.

Może Ci się również spodobać

Przegląd zmienności BTC w tygodniu (17 listopada - 1 grudnia)

Kluczowe wskaźniki (od 17 listopada godz. 16:00 czasu hongkońskiego do 1 grudnia godz. 16:00 czasu hongkońskiego) BTC/USD: -9,6% (...

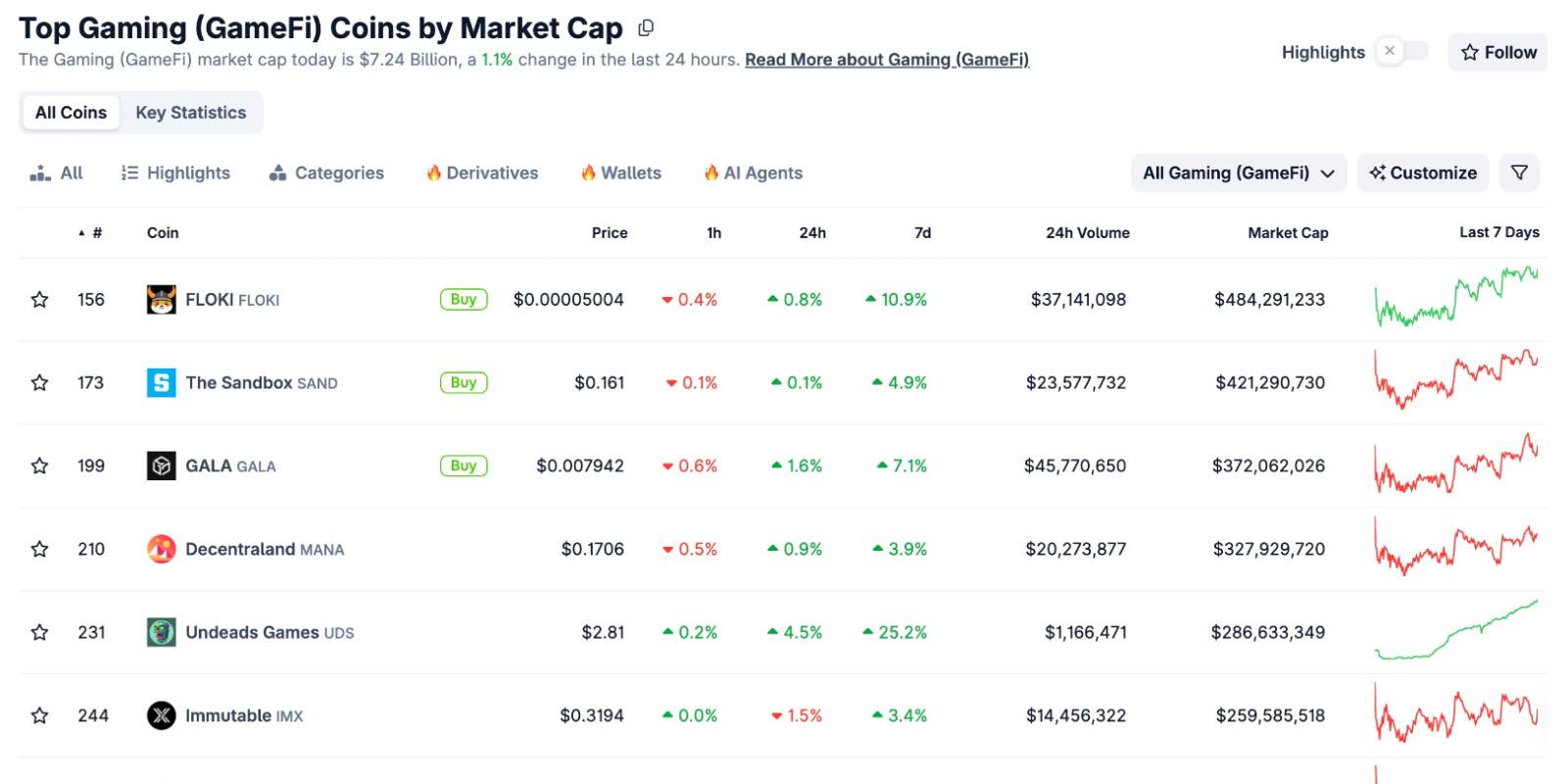

Gdy wszystkie tokeny GameFi wypadły z TOP100, czy COC może wykorzystać model ekonomiczny bitcoin, aby ponownie rozpalić narrację?

27 listopada rozpoczęto wydobycie $COC. Okazja na zdobycie pierwszych nagród z kopania nie będzie czekać na nikogo.

Kolejna dekada Ethereum: od „weryfikowalnego komputera” do „własności internetu”

Założyciel LambdaClass, Fede, szczegółowo wyjaśnia antykruchość, cel skalowania do 1 Gigagas oraz wizję Lean Ethereum.