Tan Yuan Dong: Pagsusuri sa Katapusan ng Taon 2025 (Bahagi 1)

Ulat mula sa Xinzhiyuan

Ulat mula sa Xinzhiyuan

【Panimula ng Xinzhiyuan】Mula sa pag-apula ng sunog sa Llama 4 ngunit natanggal, hanggang sa magpasya na magtatag ng sariling negosyo, binalikan ni AI expert Tian Yuandong ang ilang mahahalagang sandali ng 2025.

Napaka-busy ko kamakailan, kaya na-delay kong gawin ang aking year-end summary hanggang pagkatapos ng Enero 1. Ngunit kahit papaano, ang mahalaga ay nagsimula na akong magsulat.

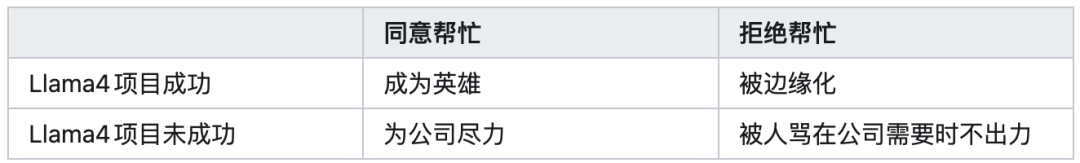

Noong huling bahagi ng Enero 2025, inatasan akong sumali saLlama4 para mag-apula ng sunog. Bilang isang tao na matagal nang nagtatrabaho sa reinforcement learning, gumuhit muna ako ng isang 2x2 reward matrix para kalkulahin ang apat na posibilidad (bagaman noon, dahil sa napakalakas na pressure mula sa itaas, halos imposible talagang tumanggi):

Noong panahong iyon, ang iniisip ko ay kahit na hindi magtagumpay ang proyekto, ginawa naman namin ang aming makakaya at malinis ang konsensya. Sa kasamaang palad, ang nangyari ay ang ikalimang posibilidad na hindi ko inaasahan, na nagbigay sa akin ng mas malalim na pag-unawa sa pagiging kumplikado ng lipunan.

Gayunpaman, sa mga buwang ito ng pagsusumikap, nagkaroon pa rin kami ng ilang paggalugad sa mga pangunahing isyu ng reinforcement learning training, tulad ng stability ng training, interaksyon ng training at inference, disenyo ng modelo, at interaksyon ng pre-training/mid-training, algorithms para sa long reasoning chains, paraan ng pagbuo ng data, disenyo ng post-training framework, at iba pa.

Mahalaga ang karanasang ito at nagdulot ng malaking pagbabago sa aking research direction.

Naisip ko rin na mahigit sampung taon na ako sa kumpanya, darating din ang araw na aalis ako, hindi naman ako pwedeng tumanda at mamatay sa kumpanya. Pero dahil sa iba’t ibang dahilan, lalo na sa pananalapi at pamilya, nanatili pa rin ako.

Nitóng isa o dalawang taon, ang paraan ko ng pagsasalita at pagkilos ay parang gusto ko nang mapaalis ng kumpanya, kaya mas naging malaya ako.

Noong katapusan ng 2023, halos umalis na ako nang magbakasyon ako ng mahaba, pero sa huli hindi ako pumirma at nanatili pa rin sa kumpanya. Kaya mahirap talaga ang mag-desisyon na umalis. Ngayon,Meta na ang nagdesisyon para sa akin, at okay lang din naman iyon.

Ang mga pagsubok na ito at ang mga pagsasalin-salin ng taon ay nagbigay din ng maraming bagong materyal para sa susunod kong pagsusulat ng nobela.

Sabi nga nila, “Kapag hindi pinalad sa karera, nagiging magaling sa tula; kapag nakaranas ng kabiguan, gumaganda ang mga likha.” Kapag masyadong payapa ang buhay, baka mawalan ng saya ang buhay. Naalala ko noong simula ng 2021, dahil lang sa ilang linyang isinulat ko sa year-end summary tungkol sa “bakit walang na-accept na paper,” bigla akong napunta sa Meet Most at parang bumagsak bigla.

Pero imbes na magreklamo sa lahat ng dako, mas pinili kong magpanggap na kakapromote ko lang sa harap ng lahat, at pagkatapos ng kalahating taon, na-promote nga ako, at iyong paper noong simula ng 2021 na walang pumansin, ay nakuha angICML Best paper honorable mention noong Hulyo 2021, at naging kilala sa larangan ng representation learning.

Pagkatapos ng Oktubre 22, halos lahat ng paraan ng komunikasyon ko ay na-overwhelm—araw-araw napakaraming mensahe, email, at mga imbitasyon sa meeting o pagkikita. Hindi ko na talaga kinaya ang lahat.

Ilang linggo rin bago bumalik sa normal. Salamat talaga sa malasakit at init ng lahat nitong nakaraang dalawang buwan. Kung may mga hindi ako nasagot agad noon, patawarin ninyo ako.

Kahit sa huli ay maraming offer, at halos lahat ng kilala ninyong kumpanya ay nag-reach out, nagdesisyon pa rin akong habang bata pa, maging co-founder ng isang bagong startup. Hindi muna ilalantad ang mga detalye, magtatrabaho muna nang tahimik.

Ang pangunahing direksyon para sa 2025 ay malalaking modelo para sa reasoning, at pagbubukas ng black box ng mga modelo.

Noong huling bahagi ng 2024, nang ilabas namin ang continuous latent space reasoning (coconut, COLM’25), naging mainit ang research direction na ito noong 2025. Sinaliksik ng lahat kung paano gamitin ito sa reinforcement learning at pre-training, paano pagbutihin ang training at computational efficiency, at iba pa.

Bagaman kinuha agad ang grupo namin para magtrabaho sa llama, at hindi na kami nakapagpatuloy ng malalim na pananaliksik, masaya pa rin ako sa naging epekto nito.

Gayunpaman, nakapaglabas pa rin kami ng isang theoretical analysis (Reasoning by Superposition, NeurIPS‘25), na nagpapakita kung saan may advantage ang continuous latent space reasoning, at nakakuha ito ng pansin.

Isa pa ay kung paano mapapabilis ang reasoning ng malalaking modelo. Ang amingToken Assorted (ICLR’25) ay gumamit muna ng VQVAE para matutunan ang discrete tokens ng latent space, tapos pinagsama ang mga ito sa text tokens para sa post-training, na nagpapababa ng inference cost habang pinapabuti ang performance.

Ang amingDeepConf ay gumagamit ng pagtukoy sa confidence ng bawat generated token para magdesisyon kung kailan tatapusin ang isang reasoning path, kaya mas kaunti ang tokens na ginagamit, pero mas maganda ang performance sa majority vote na mga scenario.

ThreadWeaver naman ay gumagawa ng parallel reasoning chains at nagpo-post-training dito para mapabilis ang reasoning. Gumamit din kami ng RL training para sa reasoning models sa dLLM (Sandwiched Policy Gradient), at nag-eksperimento rin kami sa maliit na models para sa reasoning (MobileLLM-R1).

Sa larangan ng explainability, angGrokking (biglaang pagkaunawa) ay sinusubaybayan ko na dalawang taon na. Noong dati, sa analysis ko ng representation learning, kahit na nakita ko ang learning dynamics at dahilan ng representation collapse, hindi ko pa rin maintindihan kung anong representation ang natutunan, anong relasyon nila sa input data, at anong generalization capability ang pwedeng makuha. Pero sa pagsusuri ng Grokking bilang isang phenomenon ng feature emergence, at ang proseso ng biglaang transition mula sa memory papunta sa generalization, tila nasagot ang misteryong ito.

Noong una, talagang mahirap at walang direksyon. Noong 2024, gumawa kami ng isang paper na tinatawag naCOGS (NeurIPS‘25, tingnan ang求道之人,不问寒暑(十)), pero para lang sa mga espesyal na kaso, kaya hindi ako masyadong kuntento.

Pagkatapos ng higit isang taon ng kalituhan, at sa dami ng interaksyon ko sa GPT5, nitong huling paper naProvable Scaling Laws ay may malaking breakthrough—nakita na ngayon ang mga bagay na hindi nakikita dati ng linear structures (NTK), at medyo malinaw naipaliwanag ang training dynamics ng feature emergence. Bagaman medyo espesyal pa rin ang mga halimbawa, kahit paano ay may bagong window na nabuksan. Para sa detalyadong paliwanag, tingnan ang Mga Ideya ni Tian Yuandong.

Gusto ko talaga ang year-end paper na ito, The path not taken, dahil nagbibigay ito ng paunang sagot sa kung bakit hindi magkatulad ang asal ng RL atSFT, batay sa weights.

Nagbibigay ang SFT ng overfitting atcatastrophic forgetting, ang mababaw na dahilan ay hindi sapat ang on-policy data, ngunit ang malalim na dahilan ay ang pangunahing component ng weights ay malaki ang nababago ng external data, kaya naging unstable ang “pundasyon” at bumagsak ang performance ng modelo.

Ang RL naman, dahil gumagamit ng on-policy data, ay hindi nababago ang pangunahing component ng weights, kundi ang minor components lang, kaya naiiwasan ang catastrophic forgetting, at mas sparse ang distribusyon ng mga nabagong weights (lalo na sa bf16 quantization).

Maraming tao ang nag-iisip na hindi mahalaga ang explainability, o ang tanong na “paano gumagana nang napakahusay ang AI,” pero para sa akin mahalaga ito. Isipin ang dalawang senaryo:

Senaryo 1: Kung sa pamamagitan lang ng Scaling ay abutin natin ang AGI o kahit ASI, at bumaba sa zero ang halaga ng paggawa ng tao, at ang AI bilang isang napakalaking black box ang sumagot sa lahat ng problema, ang pinakamahalaga ay paano panatilihing mabuti ang AI bilang isang super intelligent na nilalang, na hindi mandaraya o gagawa ng masama nang palihim. Para dito, kailangan talagang gawin ang explainability.

Senaryo 2: Kapag hindi na gumana ang Scaling, at natalo ang sangkatauhan sa harap ng exponentially growing resource demand, kailangan nating maghanap ng ibang solusyon. Kailangan nating isipin “bakit epektibo ang modelo, at ano ang magpapabigo dito,” at sa ganitong reasoning chain, babalik tayo sa research, at explainability ang susunod na hakbang.

Sa alinmang sitwasyon, explainability pa rin ang kakailanganin sa huli. Kahit maging all-knowing at all-good na diyos ang AI, dahil sa likas na kuryosidad ng tao, tiyak na susuriin pa rin natin kung bakit mahusay ang AI.

Pagkat ang “black box” ay nangangahulugan ng pag-usbong ng chain of suspicion. Sa panahon ng biglang pagsabog ng large model technology, na pumapantay o lumalagpas na sa karaniwang tao, ang panuntunan ng “Dark Forest” sa Three-Body Problem ay maaaring lumitaw sa ibang anyo.

Sa ngayon, ang pagbubukas ng black box ng mga natrenong modelo at paghahanap ng circuit ay nasa pangunahing yugto pa lang.

Ang tunay na hamon ng explainability ay kung paano, mula sa first principles—mula sa model architecture, gradient descent, at likas na estruktura ng data—ipaliwanag kung bakit nagkakaroon ng disentangled, sparse, low-rank, modular, at composable na features at circuits, bakit maraming iba’t ibang paliwanag, anong parameter ang konektado sa pag-emerge ng mga structure na ito, at paano sila konektado, at iba pa.

Kapag dumating ang panahon na kaya nating iderive mula sa gradient descent equation ang inevitability ng feature emergence sa malalaking modelo, doon pa lang tunay na makakamit ng explainability ang paglipat mula sa biological na koleksyon ng ebidensya tungo sa physical na derivation ng prinsipyo—at magbubukas ito ng bagong landas sa disenyo ng susunod na henerasyon ng artipisyal na intelihente.

Kung ikukumpara sa physics apatnaraang taon na ang nakalipas, marami tayong AI version ng Tycho (kolektor ng data), ilang AI version ng Kepler (gumagawa ng hypothesis), ngunit wala pa tayong AI version ng Newton (tagapagtuklas ng prinsipyo).

Kapag dumating ang araw na iyon, naniniwala akong magbabago ang mundo ng lubos.

Disclaimer: Ang nilalaman ng artikulong ito ay sumasalamin lamang sa opinyon ng author at hindi kumakatawan sa platform sa anumang kapasidad. Ang artikulong ito ay hindi nilayon na magsilbi bilang isang sanggunian para sa paggawa ng mga desisyon sa investment.

Baka magustuhan mo rin

Bakit Pinapansin ng Wall Street ang XRP? Isang Maikling Pagsusuri sa mga Sentimyento ng Merkado

USD/INR bumabawi habang hindi pinapansin ng mga mamumuhunan ang interbensyon ng RBI

Nakipagtulungan ang ICB Network sa Elderglade upang Manguna sa AI-Driven Retro Fantasy Gaming