Debutto nel 2026: Jensen Huang lancia una "bomba nucleare" da 2,5 tonnellate al CES2026

Mostra l'originale

Per:爱范儿

*C’è un piccolo video bonus alla fine. Per la prima volta in 5 anni, Nvidia non ha lanciato una scheda grafica consumer al CES. Il CEO Jensen Huang avanza deciso verso il centro del palco di NVIDIA Live, indossando ancora la stessa giacca di pelle di coccodrillo lucida dell’anno scorso.  A differenza del keynote esclusivo dell’anno scorso, nel 2026 Jensen Huang ha una tabella di marcia serrata. Da NVIDIA Live al dialogo sull’AI industriale con Siemens, fino al Lenovo TechWorld, in 48 ore ha partecipato a tre eventi. L’ultima volta, aveva presentato la serie di schede grafiche RTX 50 al CES. Questa volta, invece, l’AI fisica, la robotica e una macchina da 2,5 tonnellate di “ bomba nucleare aziendale ” sono diventate le vere protagoniste. Debutta la piattaforma di calcolo Vera Rubin, più ne compri, più risparmi Durante la conferenza, il creativo Jensen Huang ha portato sul palco direttamente un rack server AI da 2,5 tonnellate, introducendo così il focus dell’evento: la piattaforma di calcolo Vera Rubin, intitolata all’astronoma che ha scoperto la materia oscura, con un solo obiettivo: Accelerare la velocità di addestramento dell’AI e anticipare l’arrivo della prossima generazione di modelli.

A differenza del keynote esclusivo dell’anno scorso, nel 2026 Jensen Huang ha una tabella di marcia serrata. Da NVIDIA Live al dialogo sull’AI industriale con Siemens, fino al Lenovo TechWorld, in 48 ore ha partecipato a tre eventi. L’ultima volta, aveva presentato la serie di schede grafiche RTX 50 al CES. Questa volta, invece, l’AI fisica, la robotica e una macchina da 2,5 tonnellate di “ bomba nucleare aziendale ” sono diventate le vere protagoniste. Debutta la piattaforma di calcolo Vera Rubin, più ne compri, più risparmi Durante la conferenza, il creativo Jensen Huang ha portato sul palco direttamente un rack server AI da 2,5 tonnellate, introducendo così il focus dell’evento: la piattaforma di calcolo Vera Rubin, intitolata all’astronoma che ha scoperto la materia oscura, con un solo obiettivo: Accelerare la velocità di addestramento dell’AI e anticipare l’arrivo della prossima generazione di modelli.  Normalmente, in Nvidia c’è una regola: ogni generazione di prodotto cambia al massimo solo 1-2 chip. Ma questa volta Vera Rubin ha rotto gli schemi, ridisegnando ben 6 chip in una sola volta, già entrati in piena produzione.

Normalmente, in Nvidia c’è una regola: ogni generazione di prodotto cambia al massimo solo 1-2 chip. Ma questa volta Vera Rubin ha rotto gli schemi, ridisegnando ben 6 chip in una sola volta, già entrati in piena produzione.

Il motivo è che, con il rallentamento della legge di Moore, i metodi tradizionali di aumento delle prestazioni non riescono più a tenere il passo con la crescita 10x annua dei modelli AI. Così Nvidia ha scelto il “design estremamente sinergico”: innovazione simultanea su tutti i chip e a ogni livello della piattaforma. Questi 6 chip sono: 1. Vera CPU: - 88 core Olympus personalizzati da NVIDIA - Tecnologia NVIDIA multithreading spaziale, supporta 176 thread - Larghezza di banda NVLink C2C 1,8 TB/s - Memoria di sistema 1,5 TB (3 volte quella di Grace) - Larghezza di banda LPDDR5X 1,2 TB/s - 22,7 miliardi di transistor

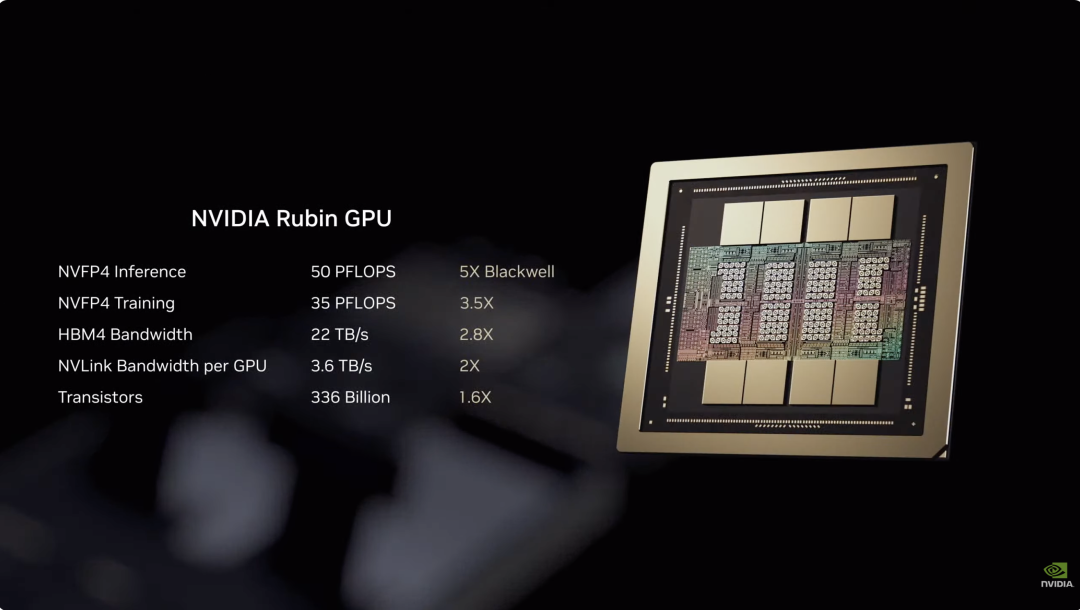

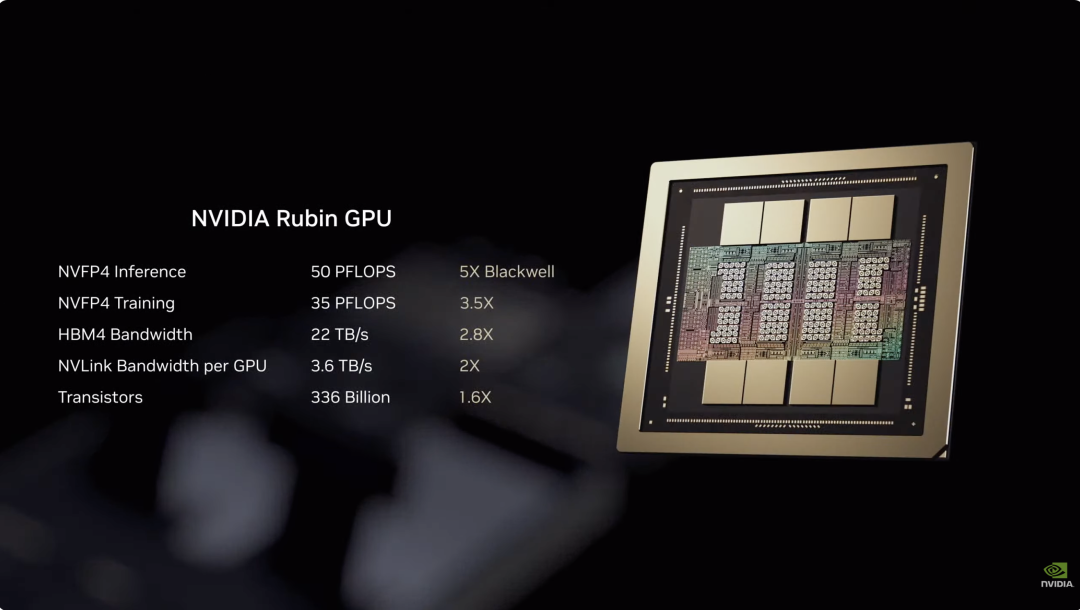

Questi 6 chip sono: 1. Vera CPU: - 88 core Olympus personalizzati da NVIDIA - Tecnologia NVIDIA multithreading spaziale, supporta 176 thread - Larghezza di banda NVLink C2C 1,8 TB/s - Memoria di sistema 1,5 TB (3 volte quella di Grace) - Larghezza di banda LPDDR5X 1,2 TB/s - 22,7 miliardi di transistor  2. Rubin GPU: - Potenza di inferenza NVFP4 50PFLOPS, 5 volte quella della precedente Blackwell - 336 miliardi di transistor, 1,6 volte quelli di Blackwell - Terza generazione di motore Transformer, adatta dinamicamente la precisione secondo le esigenze del modello Transformer

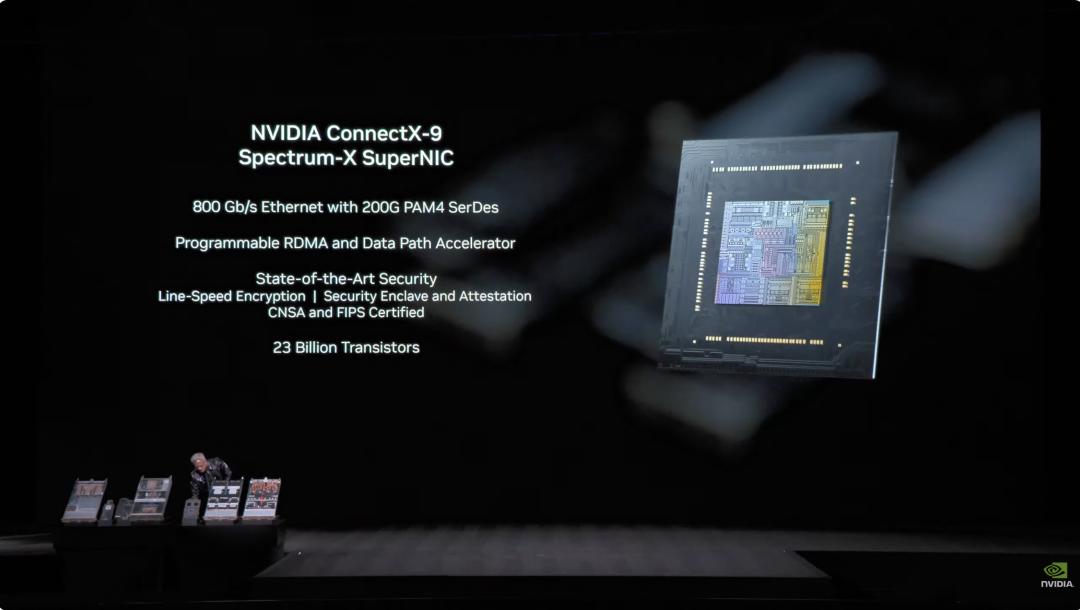

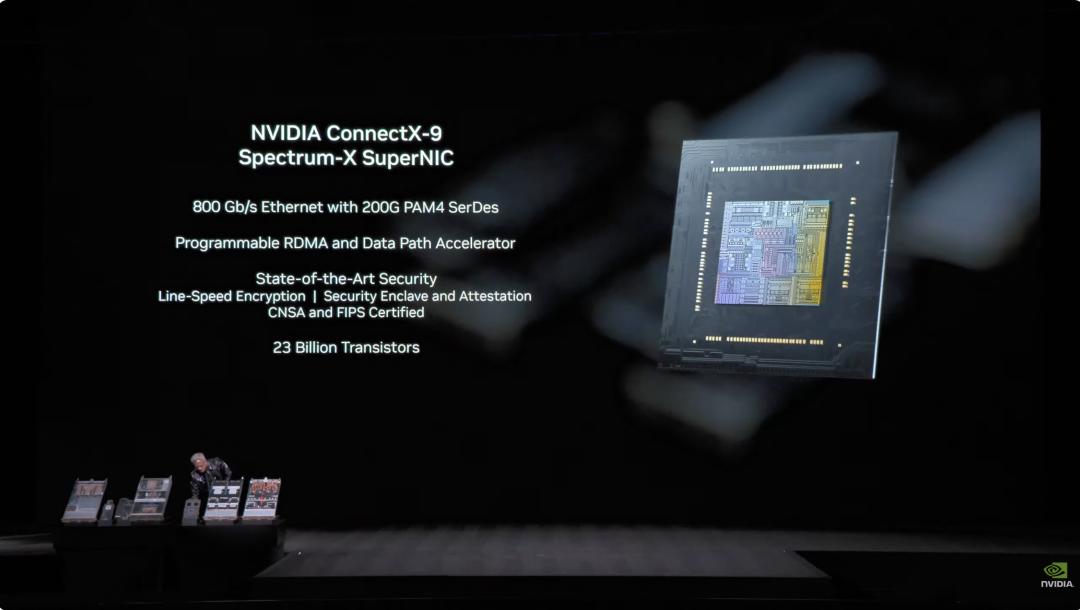

2. Rubin GPU: - Potenza di inferenza NVFP4 50PFLOPS, 5 volte quella della precedente Blackwell - 336 miliardi di transistor, 1,6 volte quelli di Blackwell - Terza generazione di motore Transformer, adatta dinamicamente la precisione secondo le esigenze del modello Transformer  3. Scheda di rete ConnectX-9: - Ethernet 800 Gb/s basata su 200G PAM4 SerDes - RDMA programmabile e acceleratore del percorso dati - Certificata CNSA e FIPS - 23 miliardi di transistor

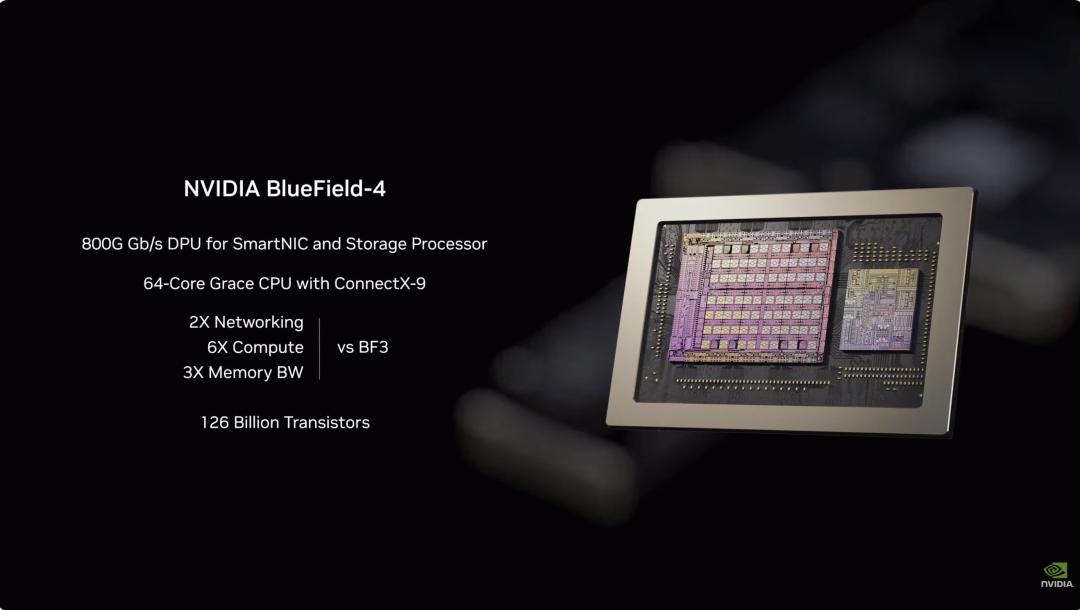

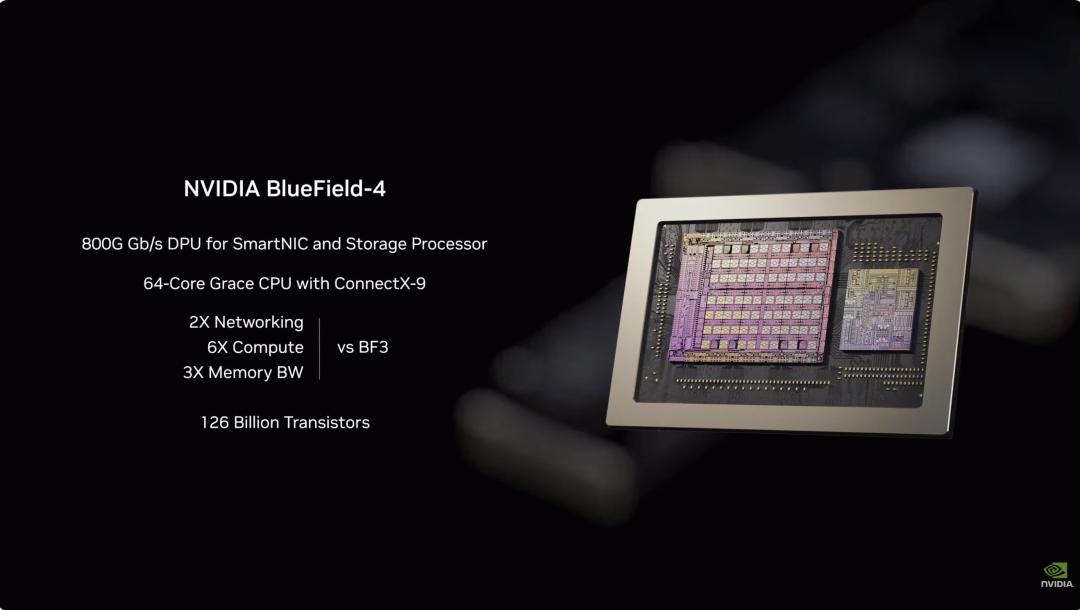

3. Scheda di rete ConnectX-9: - Ethernet 800 Gb/s basata su 200G PAM4 SerDes - RDMA programmabile e acceleratore del percorso dati - Certificata CNSA e FIPS - 23 miliardi di transistor  4. BlueField-4 DPU: - Motore end-to-end progettato per la nuova generazione di piattaforme di storage AI - DPU da 800G Gb/s per SmartNIC e processori di storage - CPU Grace a 64 core abbinata a ConnectX-9 - 126 miliardi di transistor

4. BlueField-4 DPU: - Motore end-to-end progettato per la nuova generazione di piattaforme di storage AI - DPU da 800G Gb/s per SmartNIC e processori di storage - CPU Grace a 64 core abbinata a ConnectX-9 - 126 miliardi di transistor  5. Chip di commutazione NVLink-6: - Connette 18 nodi di calcolo, supportando fino a 72 Rubin GPU che lavorano in modo collaborativo come un unico sistema - Con l’architettura NVLink 6, ogni GPU può avere 3,6 TB/s di larghezza di banda all-to-all - Usa 400G SerDes, supporta In-Network SHARP Collectives, permettendo comunicazioni collettive direttamente all’interno della rete di switch

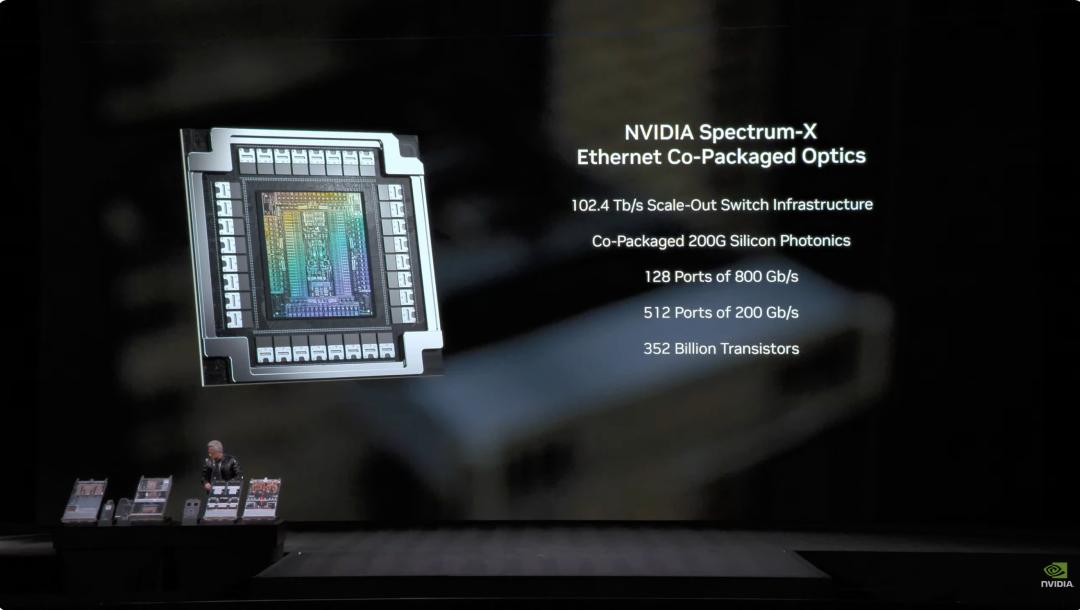

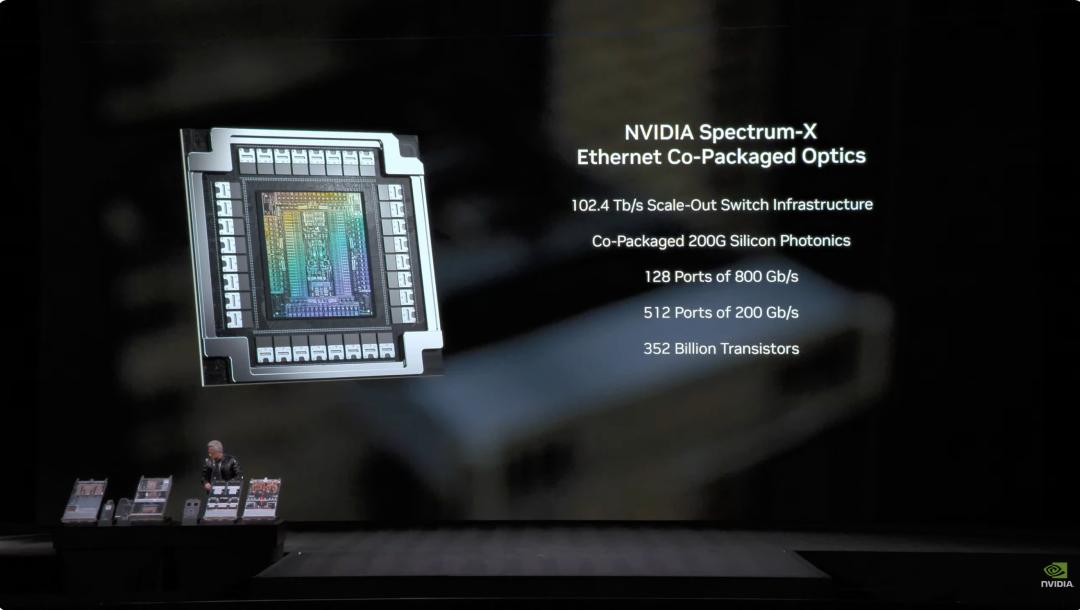

5. Chip di commutazione NVLink-6: - Connette 18 nodi di calcolo, supportando fino a 72 Rubin GPU che lavorano in modo collaborativo come un unico sistema - Con l’architettura NVLink 6, ogni GPU può avere 3,6 TB/s di larghezza di banda all-to-all - Usa 400G SerDes, supporta In-Network SHARP Collectives, permettendo comunicazioni collettive direttamente all’interno della rete di switch  6. Chip di commutazione ottica Ethernet Spectrum-6 - 512 canali, ciascuno a 200Gbps, per una trasmissione dati ancora più veloce - Integrazione della tecnologia silicon photonics con processo COOP di TSMC - Dotato di ottica copackaged - 352 miliardi di transistor

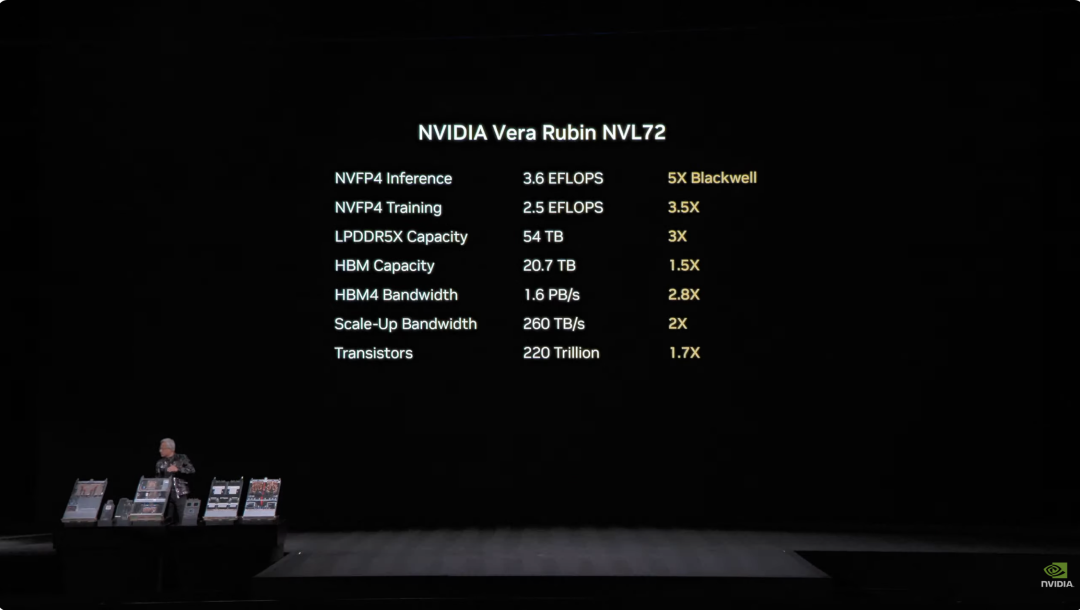

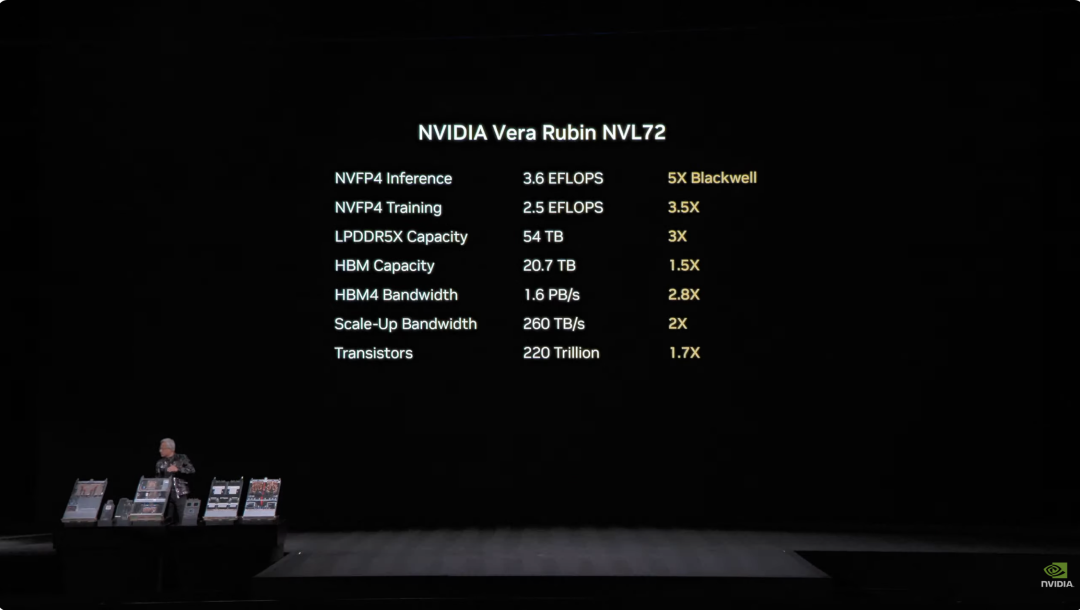

6. Chip di commutazione ottica Ethernet Spectrum-6 - 512 canali, ciascuno a 200Gbps, per una trasmissione dati ancora più veloce - Integrazione della tecnologia silicon photonics con processo COOP di TSMC - Dotato di ottica copackaged - 352 miliardi di transistor  Grazie all’integrazione profonda dei 6 chip, il sistema Vera Rubin NVL72 migliora le prestazioni a tutto tondo rispetto alla precedente generazione Blackwell. Nei task di inferenza NVFP4, questo chip raggiunge una potenza di 3,6 EFLOPS, 5 volte superiore all’architettura Blackwell precedente. Nell’addestramento NVFP4, arriva a 2,5 EFLOPS, con un incremento di 3,5 volte. Per la capacità di memoria, NVL72 offre 54TB di memoria LPDDR5X, 3 volte il prodotto della generazione precedente. La memoria HBM (High Bandwidth Memory) arriva a 20,7TB, un aumento di 1,5 volte. In termini di banda, la HBM4 arriva a 1,6 PB/s (+2,8x); la banda Scale-Up tocca i 260 TB/s (+2x). Nonostante questo enorme salto di prestazioni, il numero di transistor è aumentato solo di 1,7 volte, raggiungendo 220 trilioni, dimostrando la capacità innovativa nel manufacturing dei semiconduttori.

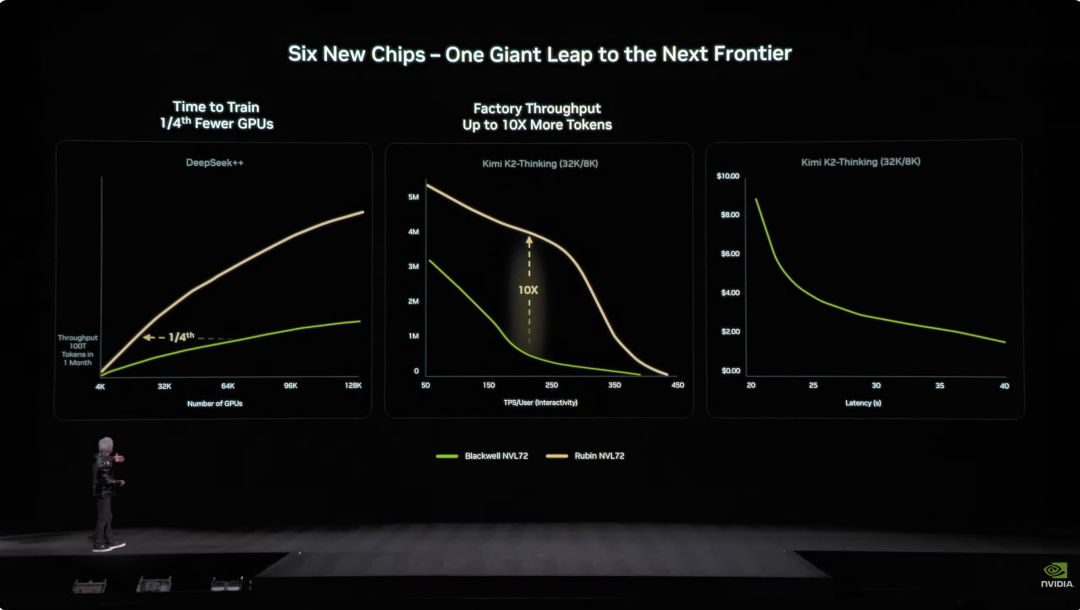

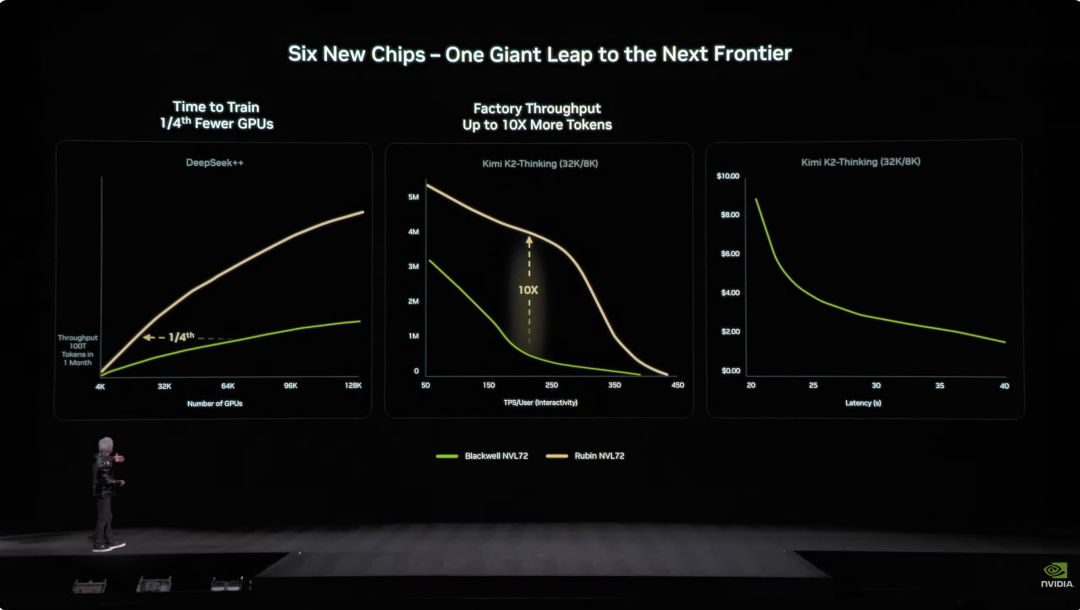

Grazie all’integrazione profonda dei 6 chip, il sistema Vera Rubin NVL72 migliora le prestazioni a tutto tondo rispetto alla precedente generazione Blackwell. Nei task di inferenza NVFP4, questo chip raggiunge una potenza di 3,6 EFLOPS, 5 volte superiore all’architettura Blackwell precedente. Nell’addestramento NVFP4, arriva a 2,5 EFLOPS, con un incremento di 3,5 volte. Per la capacità di memoria, NVL72 offre 54TB di memoria LPDDR5X, 3 volte il prodotto della generazione precedente. La memoria HBM (High Bandwidth Memory) arriva a 20,7TB, un aumento di 1,5 volte. In termini di banda, la HBM4 arriva a 1,6 PB/s (+2,8x); la banda Scale-Up tocca i 260 TB/s (+2x). Nonostante questo enorme salto di prestazioni, il numero di transistor è aumentato solo di 1,7 volte, raggiungendo 220 trilioni, dimostrando la capacità innovativa nel manufacturing dei semiconduttori.  Anche sotto il profilo dell’ingegneria, Vera Rubin rappresenta un passo avanti tecnologico. I vecchi nodi supercomputing avevano bisogno di collegare 43 cavi e ci volevano 2 ore per l’assemblaggio, con un alto rischio di errore. Ora i nodi Vera Rubin usano zero cavi, solo 6 tubi di raffreddamento a liquido, e si montano in 5 minuti. Ancora più sorprendente, il retro del rack è pieno di quasi 3,2 km di cavi di rame: 5.000 cavi costituiscono la dorsale NVLink, raggiungendo 400Gbps di velocità di trasmissione. Come ha detto Jensen Huang: “Potrebbero pesare diverse centinaia di libbre, devi essere un CEO in gran forma per questo lavoro”. Nel mondo AI il tempo è denaro: per addestrare un modello da 100 trilioni di parametri, Rubin richiede solo 1/4 del numero di sistemi Blackwell, e il costo per generare un token è circa 1/10 di quello di Blackwell.

Anche sotto il profilo dell’ingegneria, Vera Rubin rappresenta un passo avanti tecnologico. I vecchi nodi supercomputing avevano bisogno di collegare 43 cavi e ci volevano 2 ore per l’assemblaggio, con un alto rischio di errore. Ora i nodi Vera Rubin usano zero cavi, solo 6 tubi di raffreddamento a liquido, e si montano in 5 minuti. Ancora più sorprendente, il retro del rack è pieno di quasi 3,2 km di cavi di rame: 5.000 cavi costituiscono la dorsale NVLink, raggiungendo 400Gbps di velocità di trasmissione. Come ha detto Jensen Huang: “Potrebbero pesare diverse centinaia di libbre, devi essere un CEO in gran forma per questo lavoro”. Nel mondo AI il tempo è denaro: per addestrare un modello da 100 trilioni di parametri, Rubin richiede solo 1/4 del numero di sistemi Blackwell, e il costo per generare un token è circa 1/10 di quello di Blackwell.  Inoltre, anche se il consumo energetico di Rubin è doppio rispetto a Grace Blackwell, il salto prestazionale è molto superiore: +5x nell’inferenza, +3,5x nell’addestramento. Ancora più importante, la produttività di Rubin (token AI per watt-per-dollaro) è aumentata di 10 volte rispetto a Blackwell. Per un data center da 50 miliardi di dollari e un gigawatt, ciò significa che la capacità di ricavo può raddoppiare direttamente. Il problema più grande del settore AI era la memoria di contesto insufficiente. In pratica, l’AI durante il lavoro genera una “KV Cache” (cache chiave-valore), ovvero la “memoria di lavoro” dell’AI. Ma, con dialoghi più lunghi e modelli più grandi, la memoria HBM risulta limitata.

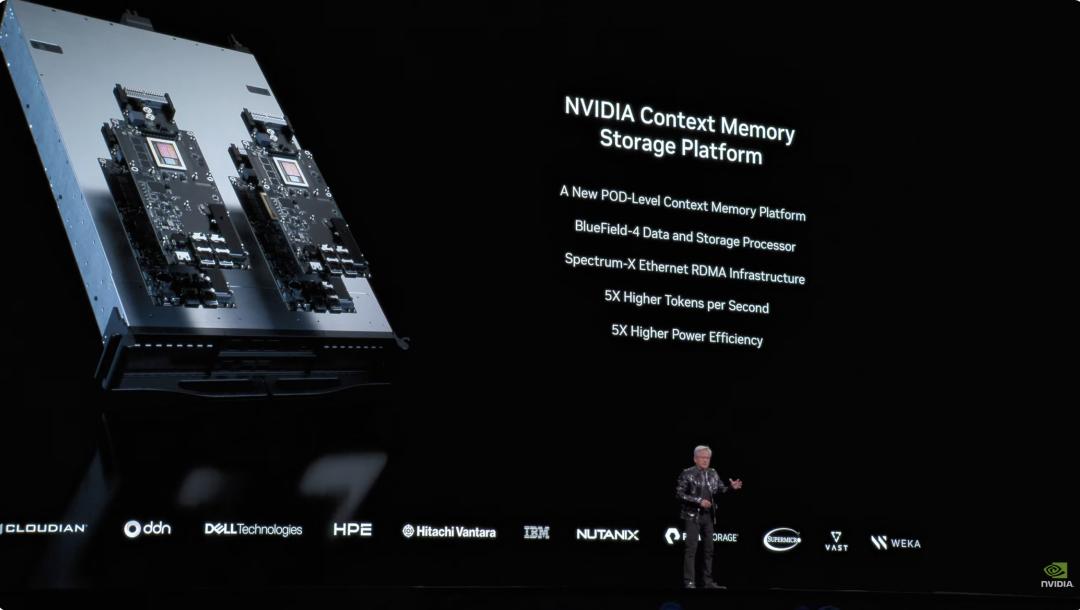

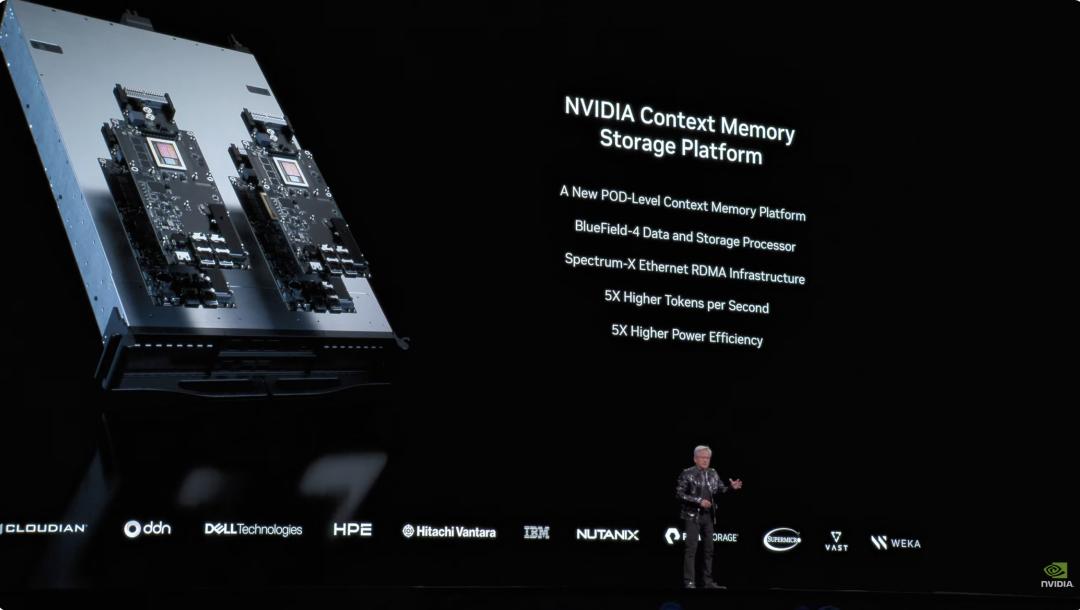

Inoltre, anche se il consumo energetico di Rubin è doppio rispetto a Grace Blackwell, il salto prestazionale è molto superiore: +5x nell’inferenza, +3,5x nell’addestramento. Ancora più importante, la produttività di Rubin (token AI per watt-per-dollaro) è aumentata di 10 volte rispetto a Blackwell. Per un data center da 50 miliardi di dollari e un gigawatt, ciò significa che la capacità di ricavo può raddoppiare direttamente. Il problema più grande del settore AI era la memoria di contesto insufficiente. In pratica, l’AI durante il lavoro genera una “KV Cache” (cache chiave-valore), ovvero la “memoria di lavoro” dell’AI. Ma, con dialoghi più lunghi e modelli più grandi, la memoria HBM risulta limitata.  L’anno scorso Nvidia ha presentato l’architettura Grace-Blackwell per espandere la memoria, ma non bastava ancora. La soluzione Vera Rubin prevede invece l’installazione di processori BlueField-4 nel rack, dedicati alla gestione della KV Cache. Ogni nodo ha 4 BlueField-4, ognuno con 150TB di memoria di contesto, che viene distribuita alle GPU. Ogni GPU ottiene così ulteriori 16TB di memoria, mentre la memoria nativa della GPU è circa 1TB. E soprattutto, la banda rimane a 200Gbps, senza perdita di velocità. Ma non basta solo la capacità: per far sì che i “post-it” distribuiti su decine di rack e migliaia di GPU lavorino come un’unica memoria, la rete deve essere “abbastanza grande, veloce e stabile”. Qui entra in gioco Spectrum-X. Spectrum-X è la prima piattaforma Ethernet end-to-end “progettata per l’AI generativa” a livello mondiale, realizzata da Nvidia. L’ultima generazione di Spectrum-X usa il processo COOP di TSMC, integra la silicon photonics, con 512 canali a 200Gbps ciascuno. Jensen Huang ha fatto due calcoli: un data center da un gigawatt costa 50 miliardi di dollari, Spectrum-X migliora la produttività del 25%, equivalendo a un risparmio di 5 miliardi di dollari. “Si può dire che questo sistema di rete è quasi ‘gratis’.” In tema sicurezza, Vera Rubin supporta anche il Confidential Computing. Tutti i dati sono cifrati in ogni fase di trasporto, archiviazione ed elaborazione, inclusi i bus PCIe, NVLink, comunicazione CPU-GPU e tutte le interconnessioni. Le aziende possono così implementare i loro modelli su sistemi esterni senza preoccuparsi di fughe di dati. DeepSeek ha sconvolto il mondo, open source e agenti sono la tendenza AI Terminata la parte principale, torniamo all’inizio del discorso. Appena salito sul palco, Jensen Huang ha lanciato un dato impressionante: circa 10 trilioni di dollari di risorse di calcolo investite nell’ultimo decennio stanno subendo una completa modernizzazione. Ma non si tratta solo di un aggiornamento hardware, bensì di un cambio di paradigma software. Ha menzionato in particolare i modelli di agenti dotati di capacità comportamentali autonome, citando Cursor, che ha rivoluzionato il modo di programmare interno a Nvidia.

L’anno scorso Nvidia ha presentato l’architettura Grace-Blackwell per espandere la memoria, ma non bastava ancora. La soluzione Vera Rubin prevede invece l’installazione di processori BlueField-4 nel rack, dedicati alla gestione della KV Cache. Ogni nodo ha 4 BlueField-4, ognuno con 150TB di memoria di contesto, che viene distribuita alle GPU. Ogni GPU ottiene così ulteriori 16TB di memoria, mentre la memoria nativa della GPU è circa 1TB. E soprattutto, la banda rimane a 200Gbps, senza perdita di velocità. Ma non basta solo la capacità: per far sì che i “post-it” distribuiti su decine di rack e migliaia di GPU lavorino come un’unica memoria, la rete deve essere “abbastanza grande, veloce e stabile”. Qui entra in gioco Spectrum-X. Spectrum-X è la prima piattaforma Ethernet end-to-end “progettata per l’AI generativa” a livello mondiale, realizzata da Nvidia. L’ultima generazione di Spectrum-X usa il processo COOP di TSMC, integra la silicon photonics, con 512 canali a 200Gbps ciascuno. Jensen Huang ha fatto due calcoli: un data center da un gigawatt costa 50 miliardi di dollari, Spectrum-X migliora la produttività del 25%, equivalendo a un risparmio di 5 miliardi di dollari. “Si può dire che questo sistema di rete è quasi ‘gratis’.” In tema sicurezza, Vera Rubin supporta anche il Confidential Computing. Tutti i dati sono cifrati in ogni fase di trasporto, archiviazione ed elaborazione, inclusi i bus PCIe, NVLink, comunicazione CPU-GPU e tutte le interconnessioni. Le aziende possono così implementare i loro modelli su sistemi esterni senza preoccuparsi di fughe di dati. DeepSeek ha sconvolto il mondo, open source e agenti sono la tendenza AI Terminata la parte principale, torniamo all’inizio del discorso. Appena salito sul palco, Jensen Huang ha lanciato un dato impressionante: circa 10 trilioni di dollari di risorse di calcolo investite nell’ultimo decennio stanno subendo una completa modernizzazione. Ma non si tratta solo di un aggiornamento hardware, bensì di un cambio di paradigma software. Ha menzionato in particolare i modelli di agenti dotati di capacità comportamentali autonome, citando Cursor, che ha rivoluzionato il modo di programmare interno a Nvidia.  Ciò che ha infiammato la platea è stata la sua valutazione estremamente positiva della comunità open source. Jensen Huang ha dichiarato che il breakthrough di DeepSeek V1 dell’anno scorso ha sorpreso il mondo intero: come primo sistema open source di inferenza, ha dato il via a un’ondata di sviluppo in tutto il settore. Nella slide, i player cinesi Kimi k2 e DeepSeek V3.2 sono rispettivamente primo e secondo tra i modelli open source. Secondo Jensen Huang, sebbene i modelli open source oggi siano forse indietro di circa sei mesi rispetto ai top di gamma, ogni sei mesi ne emerge uno nuovo. Questa velocità di iterazione è irresistibile per startup, colossi e ricercatori, inclusa Nvidia stessa. Così, questa volta non si sono limitati a vendere pale o schede grafiche; Nvidia ha costruito il supercomputer DGX Cloud dal valore di miliardi di dollari e sviluppato modelli d’avanguardia come La Proteina (sintesi proteica) e OpenFold 3.

Ciò che ha infiammato la platea è stata la sua valutazione estremamente positiva della comunità open source. Jensen Huang ha dichiarato che il breakthrough di DeepSeek V1 dell’anno scorso ha sorpreso il mondo intero: come primo sistema open source di inferenza, ha dato il via a un’ondata di sviluppo in tutto il settore. Nella slide, i player cinesi Kimi k2 e DeepSeek V3.2 sono rispettivamente primo e secondo tra i modelli open source. Secondo Jensen Huang, sebbene i modelli open source oggi siano forse indietro di circa sei mesi rispetto ai top di gamma, ogni sei mesi ne emerge uno nuovo. Questa velocità di iterazione è irresistibile per startup, colossi e ricercatori, inclusa Nvidia stessa. Così, questa volta non si sono limitati a vendere pale o schede grafiche; Nvidia ha costruito il supercomputer DGX Cloud dal valore di miliardi di dollari e sviluppato modelli d’avanguardia come La Proteina (sintesi proteica) e OpenFold 3.  L’ecosistema dei modelli open source Nvidia copre biomedicina, AI fisica, agenti, robotica e guida autonoma La famiglia di modelli open source Nvidia Nemotron è stata un altro punto forte del discorso. Include modelli per voce, multimodali, retrieval generativo aumentato e sicurezza. Huang ha anche sottolineato che i modelli open source Nemotron si sono distinti in numerose classifiche di test e sono ampiamente adottati dalle aziende. Cos’è l’AI fisica? Decine di modelli lanciati in un solo colpo Se i grandi modelli linguistici risolvono i problemi del “mondo digitale”, l’ambizione successiva di Nvidia è chiaramente quella di conquistare il “mondo fisico”. Huang ha sottolineato che per permettere all’AI di comprendere le leggi fisiche e vivere nel mondo reale servono dati estremamente rari. Oltre ai modelli open source di agenti Nemotron, ha proposto l’architettura core delle “tre tipologie di computer” per costruire l’AI fisica (Physical AI).

L’ecosistema dei modelli open source Nvidia copre biomedicina, AI fisica, agenti, robotica e guida autonoma La famiglia di modelli open source Nvidia Nemotron è stata un altro punto forte del discorso. Include modelli per voce, multimodali, retrieval generativo aumentato e sicurezza. Huang ha anche sottolineato che i modelli open source Nemotron si sono distinti in numerose classifiche di test e sono ampiamente adottati dalle aziende. Cos’è l’AI fisica? Decine di modelli lanciati in un solo colpo Se i grandi modelli linguistici risolvono i problemi del “mondo digitale”, l’ambizione successiva di Nvidia è chiaramente quella di conquistare il “mondo fisico”. Huang ha sottolineato che per permettere all’AI di comprendere le leggi fisiche e vivere nel mondo reale servono dati estremamente rari. Oltre ai modelli open source di agenti Nemotron, ha proposto l’architettura core delle “tre tipologie di computer” per costruire l’AI fisica (Physical AI).

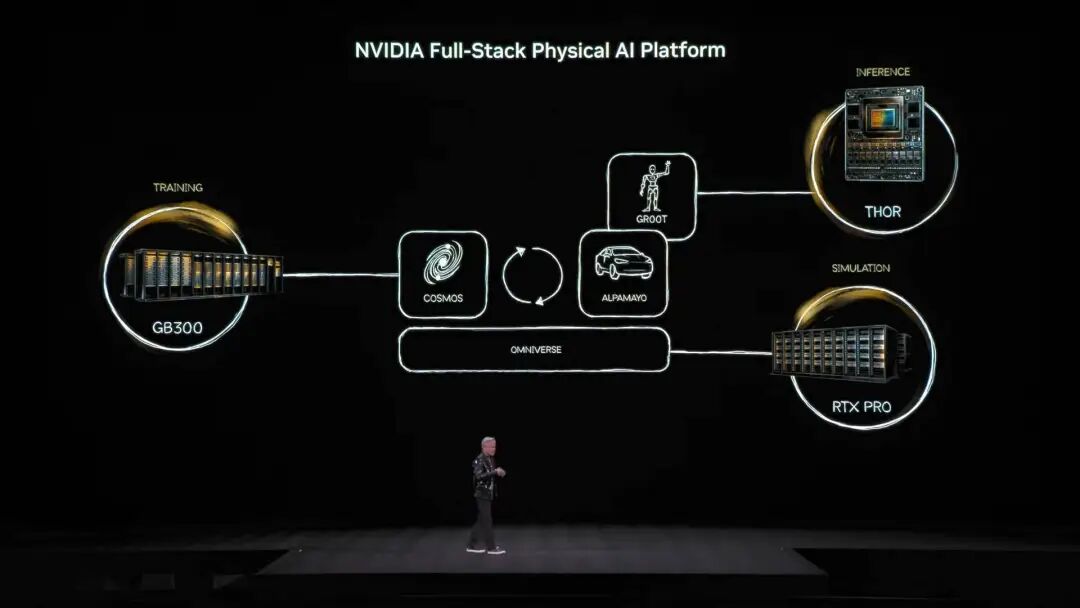

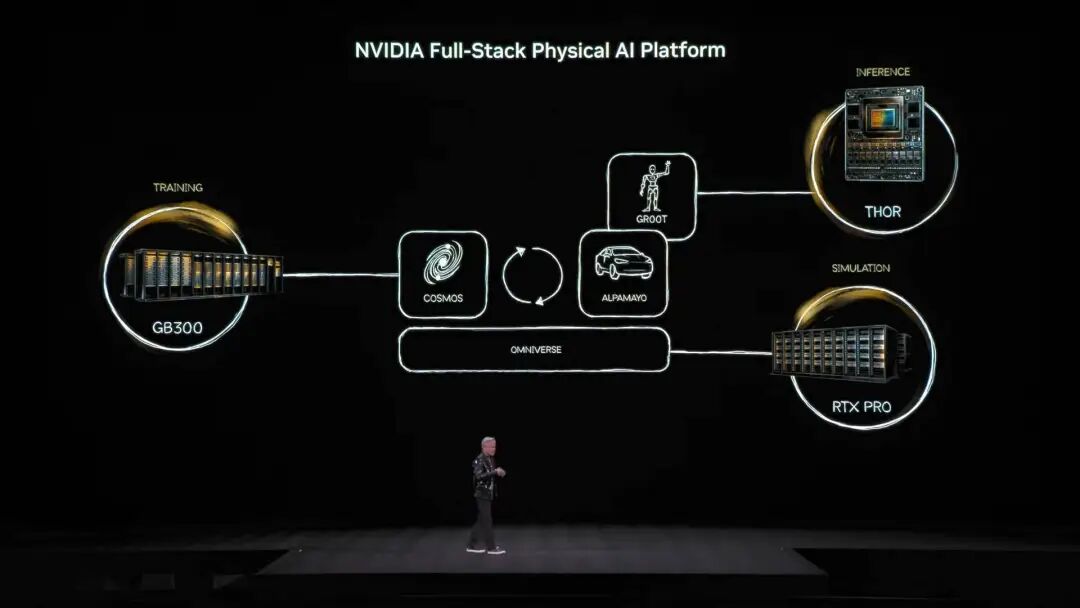

Computer di addestramento, cioè quelli costruiti con GPU di classe training, come l’architettura GB300 citata nell’immagine.

Computer di inferenza, ovvero il “cervelletto” che lavora su robot o veicoli edge, responsabile dell’esecuzione in tempo reale.

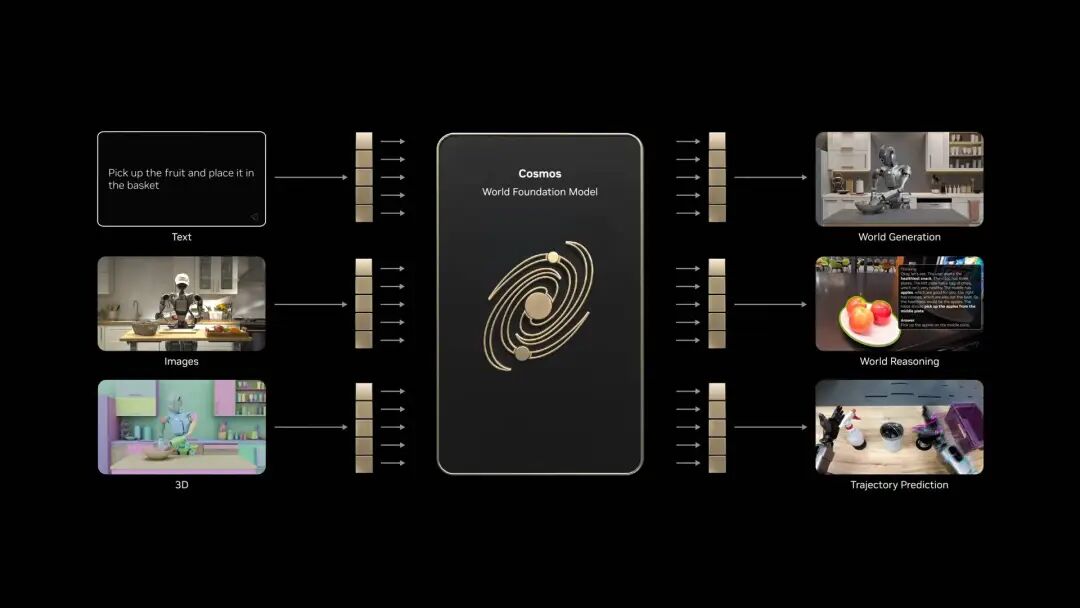

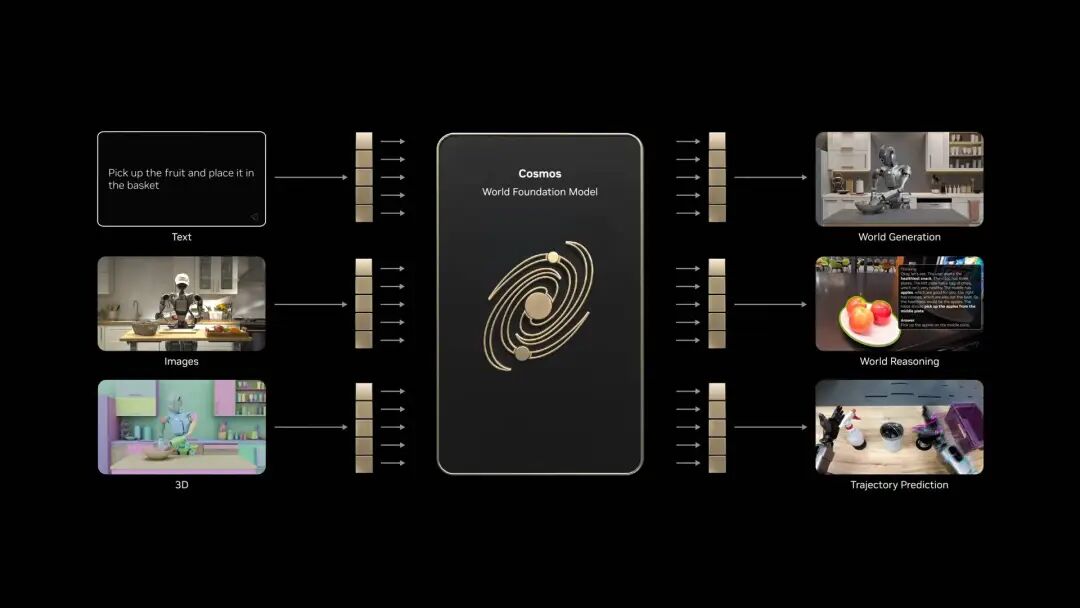

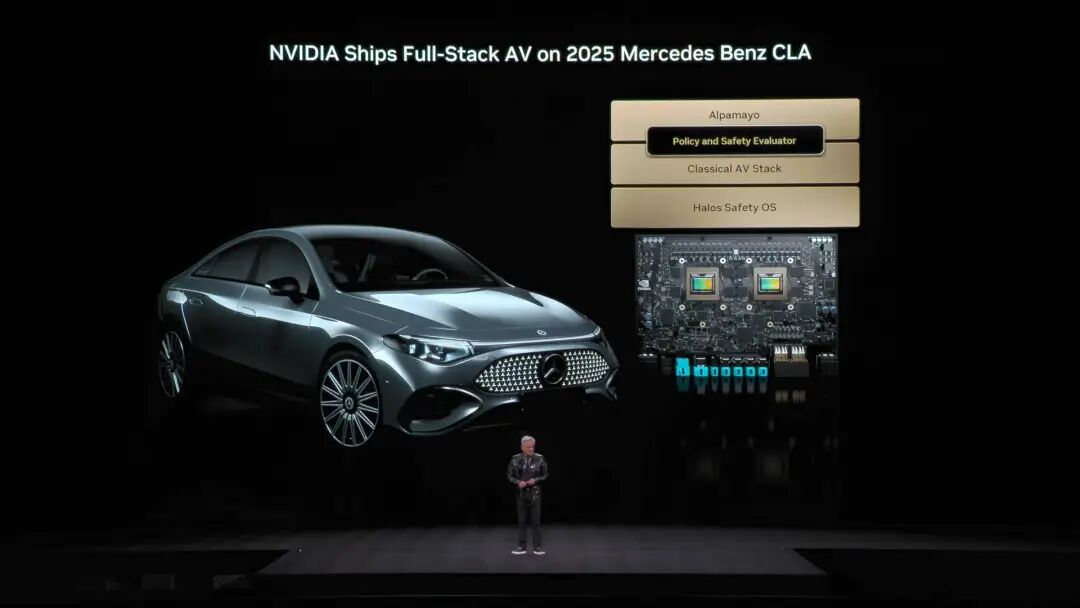

Computer di simulazione, tra cui Omniverse e Cosmos, che forniscono ambienti virtuali di training per AI, consentendole di apprendere feedback fisici tramite la simulazione. Il sistema Cosmos può generare numerosi ambienti di training AI per il mondo fisico Sulla base di questa architettura, Jensen Huang ha presentato ufficialmente Alpamayo, il primo modello di guida autonoma al mondo dotato di capacità di ragionamento e pensiero.

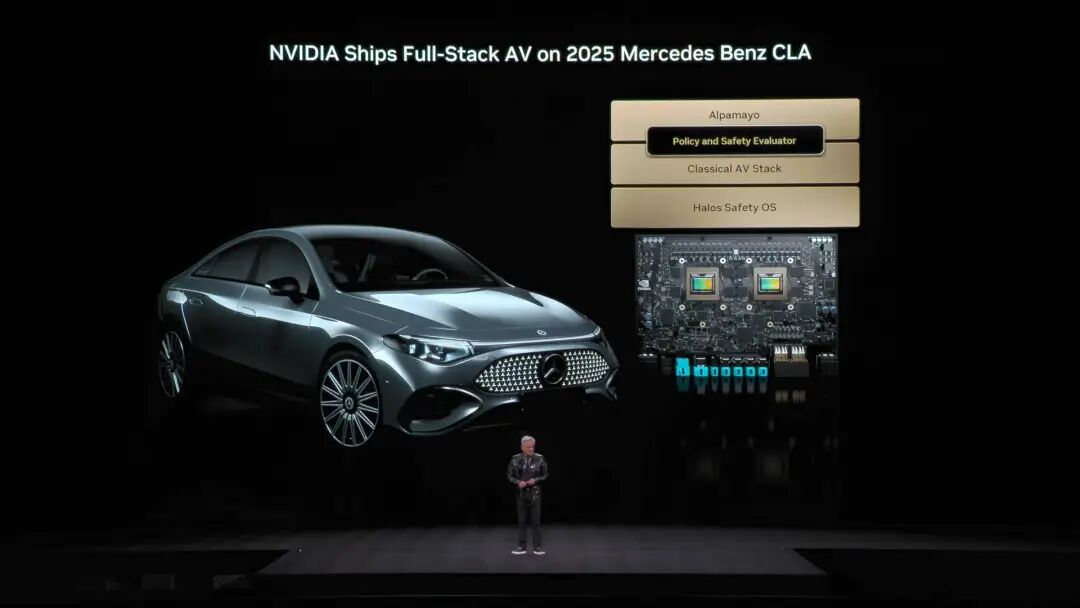

Il sistema Cosmos può generare numerosi ambienti di training AI per il mondo fisico Sulla base di questa architettura, Jensen Huang ha presentato ufficialmente Alpamayo, il primo modello di guida autonoma al mondo dotato di capacità di ragionamento e pensiero.  A differenza dei sistemi tradizionali, Alpamayo è un sistema end-to-end. La sua innovazione risiede nella soluzione del “problema della coda lunga” della guida autonoma. Di fronte a situazioni stradali mai viste prima, Alpamayo non esegue più solo codice in modo meccanico, ma può ragionare come un guidatore umano. “Ti dice cosa farà dopo, e perché prenderà quella decisione.” Durante la demo, lo stile di guida era sorprendentemente naturale, capace di scomporre scenari estremamente complessi in elementi di buon senso. Oltre alla demo, tutto ciò non è solo teoria. Jensen Huang ha annunciato che la Mercedes CLA con la tecnologia Alpamayo sarà lanciata negli Stati Uniti nel primo trimestre di quest’anno, e a seguire gradualmente in Europa e Asia.

A differenza dei sistemi tradizionali, Alpamayo è un sistema end-to-end. La sua innovazione risiede nella soluzione del “problema della coda lunga” della guida autonoma. Di fronte a situazioni stradali mai viste prima, Alpamayo non esegue più solo codice in modo meccanico, ma può ragionare come un guidatore umano. “Ti dice cosa farà dopo, e perché prenderà quella decisione.” Durante la demo, lo stile di guida era sorprendentemente naturale, capace di scomporre scenari estremamente complessi in elementi di buon senso. Oltre alla demo, tutto ciò non è solo teoria. Jensen Huang ha annunciato che la Mercedes CLA con la tecnologia Alpamayo sarà lanciata negli Stati Uniti nel primo trimestre di quest’anno, e a seguire gradualmente in Europa e Asia.  Questa vettura è stata valutata da NCAP come la più sicura al mondo, grazie al design Nvidia con “doppio stack di sicurezza”: quando il modello AI end-to-end ha poca fiducia nella situazione stradale, il sistema torna immediatamente a una modalità di sicurezza tradizionale più affidabile, garantendo la sicurezza assoluta. Alla conferenza, Jensen Huang ha anche mostrato la strategia robotica di Nvidia.

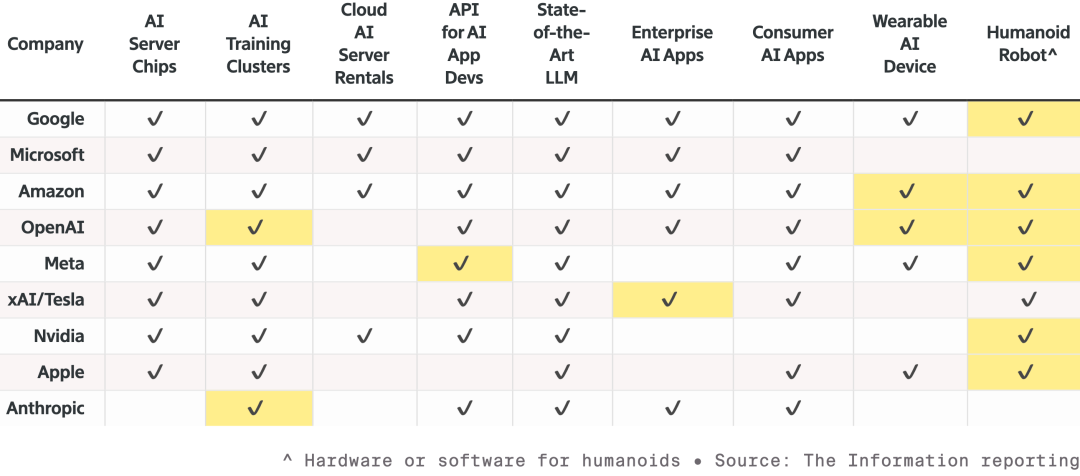

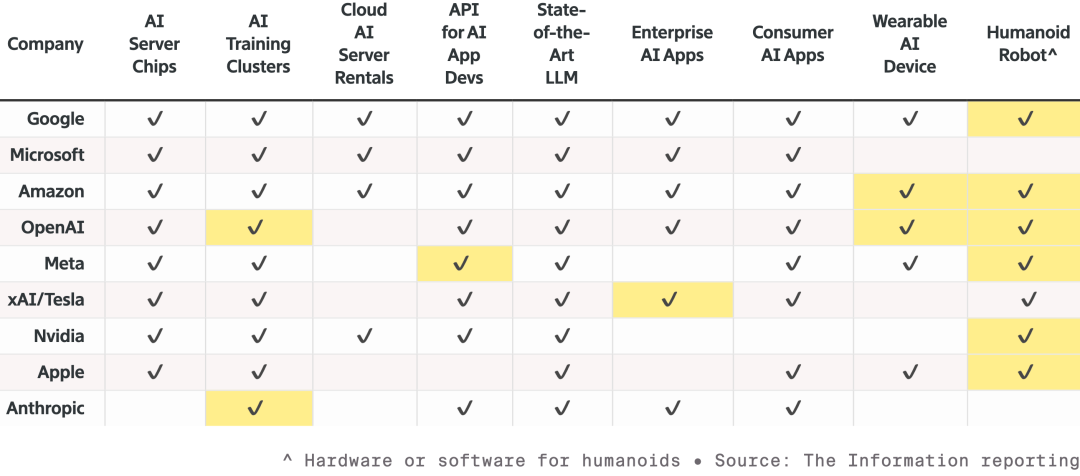

Questa vettura è stata valutata da NCAP come la più sicura al mondo, grazie al design Nvidia con “doppio stack di sicurezza”: quando il modello AI end-to-end ha poca fiducia nella situazione stradale, il sistema torna immediatamente a una modalità di sicurezza tradizionale più affidabile, garantendo la sicurezza assoluta. Alla conferenza, Jensen Huang ha anche mostrato la strategia robotica di Nvidia.  La competizione tra le nove principali aziende AI e hardware: tutte stanno ampliando la gamma prodotti, puntando in particolare al settore robotico. Le celle evidenziate rappresentano i nuovi prodotti dal 2023 a oggi. Tutti i robot avranno computer Jetson, saranno addestrati nel simulatore Isaac di Omniverse, e Nvidia sta integrando questa tecnologia nei sistemi industriali di Synopsys, Cadence, Siemens e altri.

La competizione tra le nove principali aziende AI e hardware: tutte stanno ampliando la gamma prodotti, puntando in particolare al settore robotico. Le celle evidenziate rappresentano i nuovi prodotti dal 2023 a oggi. Tutti i robot avranno computer Jetson, saranno addestrati nel simulatore Isaac di Omniverse, e Nvidia sta integrando questa tecnologia nei sistemi industriali di Synopsys, Cadence, Siemens e altri.  Jensen Huang ha invitato sul palco robot umanoidi e quadrupedi di aziende come Boston Dynamics e Agility, sottolineando che il più grande robot è in realtà la fabbrica stessa. Dal basso verso l’alto, la visione Nvidia è che in futuro la progettazione di chip, sistemi e la simulazione di fabbrica saranno tutte accelerate dall’AI fisica Nvidia. Alla presentazione, è stato protagonista anche un robot Disney; Huang ha scherzato con questi adorabili robot: “Sarete progettati al computer, costruiti al computer e persino testati e validati al computer prima di affrontare la gravità reale.”

Jensen Huang ha invitato sul palco robot umanoidi e quadrupedi di aziende come Boston Dynamics e Agility, sottolineando che il più grande robot è in realtà la fabbrica stessa. Dal basso verso l’alto, la visione Nvidia è che in futuro la progettazione di chip, sistemi e la simulazione di fabbrica saranno tutte accelerate dall’AI fisica Nvidia. Alla presentazione, è stato protagonista anche un robot Disney; Huang ha scherzato con questi adorabili robot: “Sarete progettati al computer, costruiti al computer e persino testati e validati al computer prima di affrontare la gravità reale.”  Se non fosse Jensen Huang, si potrebbe quasi pensare che questa sia stata la conferenza di un’azienda di modelli AI. Oggi, con lo scetticismo sulla presunta “bolla AI” sempre più diffuso, oltre al rallentamento della legge di Moore, Jensen Huang sembra voler rafforzare la nostra fiducia nell’AI mostrando cosa può davvero fare. Oltre a presentare la potente piattaforma di supercalcolo AI Vera Rubin per calmare la sete di potenza, ha dedicato più impegno che mai alle applicazioni e al software, facendo tutto il possibile per mostrarci quali cambiamenti tangibili porterà l’AI. Inoltre, come ha detto Jensen Huang, se in passato costruivano chip per il mondo virtuale, ora si mettono in gioco direttamente, concentrandosi su AI fisica come guida autonoma e robot umanoidi, entrando nel mondo fisico reale dove la competizione è più agguerrita. Dopotutto, solo quando la guerra è in corso si possono continuare a vendere armi. *Infine, ecco il video bonus: a causa del tempo limitato per il discorso al CES, Jensen Huang non ha potuto presentare molte slide. Così ha deciso di realizzare un divertente video con le slide non mostrate. Godetevelo⬇️

Se non fosse Jensen Huang, si potrebbe quasi pensare che questa sia stata la conferenza di un’azienda di modelli AI. Oggi, con lo scetticismo sulla presunta “bolla AI” sempre più diffuso, oltre al rallentamento della legge di Moore, Jensen Huang sembra voler rafforzare la nostra fiducia nell’AI mostrando cosa può davvero fare. Oltre a presentare la potente piattaforma di supercalcolo AI Vera Rubin per calmare la sete di potenza, ha dedicato più impegno che mai alle applicazioni e al software, facendo tutto il possibile per mostrarci quali cambiamenti tangibili porterà l’AI. Inoltre, come ha detto Jensen Huang, se in passato costruivano chip per il mondo virtuale, ora si mettono in gioco direttamente, concentrandosi su AI fisica come guida autonoma e robot umanoidi, entrando nel mondo fisico reale dove la competizione è più agguerrita. Dopotutto, solo quando la guerra è in corso si possono continuare a vendere armi. *Infine, ecco il video bonus: a causa del tempo limitato per il discorso al CES, Jensen Huang non ha potuto presentare molte slide. Così ha deciso di realizzare un divertente video con le slide non mostrate. Godetevelo⬇️

A differenza del keynote esclusivo dell’anno scorso, nel 2026 Jensen Huang ha una tabella di marcia serrata. Da NVIDIA Live al dialogo sull’AI industriale con Siemens, fino al Lenovo TechWorld, in 48 ore ha partecipato a tre eventi. L’ultima volta, aveva presentato la serie di schede grafiche RTX 50 al CES. Questa volta, invece, l’AI fisica, la robotica e una macchina da 2,5 tonnellate di “ bomba nucleare aziendale ” sono diventate le vere protagoniste. Debutta la piattaforma di calcolo Vera Rubin, più ne compri, più risparmi Durante la conferenza, il creativo Jensen Huang ha portato sul palco direttamente un rack server AI da 2,5 tonnellate, introducendo così il focus dell’evento: la piattaforma di calcolo Vera Rubin, intitolata all’astronoma che ha scoperto la materia oscura, con un solo obiettivo: Accelerare la velocità di addestramento dell’AI e anticipare l’arrivo della prossima generazione di modelli.

A differenza del keynote esclusivo dell’anno scorso, nel 2026 Jensen Huang ha una tabella di marcia serrata. Da NVIDIA Live al dialogo sull’AI industriale con Siemens, fino al Lenovo TechWorld, in 48 ore ha partecipato a tre eventi. L’ultima volta, aveva presentato la serie di schede grafiche RTX 50 al CES. Questa volta, invece, l’AI fisica, la robotica e una macchina da 2,5 tonnellate di “ bomba nucleare aziendale ” sono diventate le vere protagoniste. Debutta la piattaforma di calcolo Vera Rubin, più ne compri, più risparmi Durante la conferenza, il creativo Jensen Huang ha portato sul palco direttamente un rack server AI da 2,5 tonnellate, introducendo così il focus dell’evento: la piattaforma di calcolo Vera Rubin, intitolata all’astronoma che ha scoperto la materia oscura, con un solo obiettivo: Accelerare la velocità di addestramento dell’AI e anticipare l’arrivo della prossima generazione di modelli.  Normalmente, in Nvidia c’è una regola: ogni generazione di prodotto cambia al massimo solo 1-2 chip. Ma questa volta Vera Rubin ha rotto gli schemi, ridisegnando ben 6 chip in una sola volta, già entrati in piena produzione.

Normalmente, in Nvidia c’è una regola: ogni generazione di prodotto cambia al massimo solo 1-2 chip. Ma questa volta Vera Rubin ha rotto gli schemi, ridisegnando ben 6 chip in una sola volta, già entrati in piena produzione. Il motivo è che, con il rallentamento della legge di Moore, i metodi tradizionali di aumento delle prestazioni non riescono più a tenere il passo con la crescita 10x annua dei modelli AI. Così Nvidia ha scelto il “design estremamente sinergico”: innovazione simultanea su tutti i chip e a ogni livello della piattaforma.

Questi 6 chip sono: 1. Vera CPU: - 88 core Olympus personalizzati da NVIDIA - Tecnologia NVIDIA multithreading spaziale, supporta 176 thread - Larghezza di banda NVLink C2C 1,8 TB/s - Memoria di sistema 1,5 TB (3 volte quella di Grace) - Larghezza di banda LPDDR5X 1,2 TB/s - 22,7 miliardi di transistor

Questi 6 chip sono: 1. Vera CPU: - 88 core Olympus personalizzati da NVIDIA - Tecnologia NVIDIA multithreading spaziale, supporta 176 thread - Larghezza di banda NVLink C2C 1,8 TB/s - Memoria di sistema 1,5 TB (3 volte quella di Grace) - Larghezza di banda LPDDR5X 1,2 TB/s - 22,7 miliardi di transistor  2. Rubin GPU: - Potenza di inferenza NVFP4 50PFLOPS, 5 volte quella della precedente Blackwell - 336 miliardi di transistor, 1,6 volte quelli di Blackwell - Terza generazione di motore Transformer, adatta dinamicamente la precisione secondo le esigenze del modello Transformer

2. Rubin GPU: - Potenza di inferenza NVFP4 50PFLOPS, 5 volte quella della precedente Blackwell - 336 miliardi di transistor, 1,6 volte quelli di Blackwell - Terza generazione di motore Transformer, adatta dinamicamente la precisione secondo le esigenze del modello Transformer  3. Scheda di rete ConnectX-9: - Ethernet 800 Gb/s basata su 200G PAM4 SerDes - RDMA programmabile e acceleratore del percorso dati - Certificata CNSA e FIPS - 23 miliardi di transistor

3. Scheda di rete ConnectX-9: - Ethernet 800 Gb/s basata su 200G PAM4 SerDes - RDMA programmabile e acceleratore del percorso dati - Certificata CNSA e FIPS - 23 miliardi di transistor  4. BlueField-4 DPU: - Motore end-to-end progettato per la nuova generazione di piattaforme di storage AI - DPU da 800G Gb/s per SmartNIC e processori di storage - CPU Grace a 64 core abbinata a ConnectX-9 - 126 miliardi di transistor

4. BlueField-4 DPU: - Motore end-to-end progettato per la nuova generazione di piattaforme di storage AI - DPU da 800G Gb/s per SmartNIC e processori di storage - CPU Grace a 64 core abbinata a ConnectX-9 - 126 miliardi di transistor  5. Chip di commutazione NVLink-6: - Connette 18 nodi di calcolo, supportando fino a 72 Rubin GPU che lavorano in modo collaborativo come un unico sistema - Con l’architettura NVLink 6, ogni GPU può avere 3,6 TB/s di larghezza di banda all-to-all - Usa 400G SerDes, supporta In-Network SHARP Collectives, permettendo comunicazioni collettive direttamente all’interno della rete di switch

5. Chip di commutazione NVLink-6: - Connette 18 nodi di calcolo, supportando fino a 72 Rubin GPU che lavorano in modo collaborativo come un unico sistema - Con l’architettura NVLink 6, ogni GPU può avere 3,6 TB/s di larghezza di banda all-to-all - Usa 400G SerDes, supporta In-Network SHARP Collectives, permettendo comunicazioni collettive direttamente all’interno della rete di switch  6. Chip di commutazione ottica Ethernet Spectrum-6 - 512 canali, ciascuno a 200Gbps, per una trasmissione dati ancora più veloce - Integrazione della tecnologia silicon photonics con processo COOP di TSMC - Dotato di ottica copackaged - 352 miliardi di transistor

6. Chip di commutazione ottica Ethernet Spectrum-6 - 512 canali, ciascuno a 200Gbps, per una trasmissione dati ancora più veloce - Integrazione della tecnologia silicon photonics con processo COOP di TSMC - Dotato di ottica copackaged - 352 miliardi di transistor  Grazie all’integrazione profonda dei 6 chip, il sistema Vera Rubin NVL72 migliora le prestazioni a tutto tondo rispetto alla precedente generazione Blackwell. Nei task di inferenza NVFP4, questo chip raggiunge una potenza di 3,6 EFLOPS, 5 volte superiore all’architettura Blackwell precedente. Nell’addestramento NVFP4, arriva a 2,5 EFLOPS, con un incremento di 3,5 volte. Per la capacità di memoria, NVL72 offre 54TB di memoria LPDDR5X, 3 volte il prodotto della generazione precedente. La memoria HBM (High Bandwidth Memory) arriva a 20,7TB, un aumento di 1,5 volte. In termini di banda, la HBM4 arriva a 1,6 PB/s (+2,8x); la banda Scale-Up tocca i 260 TB/s (+2x). Nonostante questo enorme salto di prestazioni, il numero di transistor è aumentato solo di 1,7 volte, raggiungendo 220 trilioni, dimostrando la capacità innovativa nel manufacturing dei semiconduttori.

Grazie all’integrazione profonda dei 6 chip, il sistema Vera Rubin NVL72 migliora le prestazioni a tutto tondo rispetto alla precedente generazione Blackwell. Nei task di inferenza NVFP4, questo chip raggiunge una potenza di 3,6 EFLOPS, 5 volte superiore all’architettura Blackwell precedente. Nell’addestramento NVFP4, arriva a 2,5 EFLOPS, con un incremento di 3,5 volte. Per la capacità di memoria, NVL72 offre 54TB di memoria LPDDR5X, 3 volte il prodotto della generazione precedente. La memoria HBM (High Bandwidth Memory) arriva a 20,7TB, un aumento di 1,5 volte. In termini di banda, la HBM4 arriva a 1,6 PB/s (+2,8x); la banda Scale-Up tocca i 260 TB/s (+2x). Nonostante questo enorme salto di prestazioni, il numero di transistor è aumentato solo di 1,7 volte, raggiungendo 220 trilioni, dimostrando la capacità innovativa nel manufacturing dei semiconduttori.  Anche sotto il profilo dell’ingegneria, Vera Rubin rappresenta un passo avanti tecnologico. I vecchi nodi supercomputing avevano bisogno di collegare 43 cavi e ci volevano 2 ore per l’assemblaggio, con un alto rischio di errore. Ora i nodi Vera Rubin usano zero cavi, solo 6 tubi di raffreddamento a liquido, e si montano in 5 minuti. Ancora più sorprendente, il retro del rack è pieno di quasi 3,2 km di cavi di rame: 5.000 cavi costituiscono la dorsale NVLink, raggiungendo 400Gbps di velocità di trasmissione. Come ha detto Jensen Huang: “Potrebbero pesare diverse centinaia di libbre, devi essere un CEO in gran forma per questo lavoro”. Nel mondo AI il tempo è denaro: per addestrare un modello da 100 trilioni di parametri, Rubin richiede solo 1/4 del numero di sistemi Blackwell, e il costo per generare un token è circa 1/10 di quello di Blackwell.

Anche sotto il profilo dell’ingegneria, Vera Rubin rappresenta un passo avanti tecnologico. I vecchi nodi supercomputing avevano bisogno di collegare 43 cavi e ci volevano 2 ore per l’assemblaggio, con un alto rischio di errore. Ora i nodi Vera Rubin usano zero cavi, solo 6 tubi di raffreddamento a liquido, e si montano in 5 minuti. Ancora più sorprendente, il retro del rack è pieno di quasi 3,2 km di cavi di rame: 5.000 cavi costituiscono la dorsale NVLink, raggiungendo 400Gbps di velocità di trasmissione. Come ha detto Jensen Huang: “Potrebbero pesare diverse centinaia di libbre, devi essere un CEO in gran forma per questo lavoro”. Nel mondo AI il tempo è denaro: per addestrare un modello da 100 trilioni di parametri, Rubin richiede solo 1/4 del numero di sistemi Blackwell, e il costo per generare un token è circa 1/10 di quello di Blackwell.  Inoltre, anche se il consumo energetico di Rubin è doppio rispetto a Grace Blackwell, il salto prestazionale è molto superiore: +5x nell’inferenza, +3,5x nell’addestramento. Ancora più importante, la produttività di Rubin (token AI per watt-per-dollaro) è aumentata di 10 volte rispetto a Blackwell. Per un data center da 50 miliardi di dollari e un gigawatt, ciò significa che la capacità di ricavo può raddoppiare direttamente. Il problema più grande del settore AI era la memoria di contesto insufficiente. In pratica, l’AI durante il lavoro genera una “KV Cache” (cache chiave-valore), ovvero la “memoria di lavoro” dell’AI. Ma, con dialoghi più lunghi e modelli più grandi, la memoria HBM risulta limitata.

Inoltre, anche se il consumo energetico di Rubin è doppio rispetto a Grace Blackwell, il salto prestazionale è molto superiore: +5x nell’inferenza, +3,5x nell’addestramento. Ancora più importante, la produttività di Rubin (token AI per watt-per-dollaro) è aumentata di 10 volte rispetto a Blackwell. Per un data center da 50 miliardi di dollari e un gigawatt, ciò significa che la capacità di ricavo può raddoppiare direttamente. Il problema più grande del settore AI era la memoria di contesto insufficiente. In pratica, l’AI durante il lavoro genera una “KV Cache” (cache chiave-valore), ovvero la “memoria di lavoro” dell’AI. Ma, con dialoghi più lunghi e modelli più grandi, la memoria HBM risulta limitata.  L’anno scorso Nvidia ha presentato l’architettura Grace-Blackwell per espandere la memoria, ma non bastava ancora. La soluzione Vera Rubin prevede invece l’installazione di processori BlueField-4 nel rack, dedicati alla gestione della KV Cache. Ogni nodo ha 4 BlueField-4, ognuno con 150TB di memoria di contesto, che viene distribuita alle GPU. Ogni GPU ottiene così ulteriori 16TB di memoria, mentre la memoria nativa della GPU è circa 1TB. E soprattutto, la banda rimane a 200Gbps, senza perdita di velocità. Ma non basta solo la capacità: per far sì che i “post-it” distribuiti su decine di rack e migliaia di GPU lavorino come un’unica memoria, la rete deve essere “abbastanza grande, veloce e stabile”. Qui entra in gioco Spectrum-X. Spectrum-X è la prima piattaforma Ethernet end-to-end “progettata per l’AI generativa” a livello mondiale, realizzata da Nvidia. L’ultima generazione di Spectrum-X usa il processo COOP di TSMC, integra la silicon photonics, con 512 canali a 200Gbps ciascuno. Jensen Huang ha fatto due calcoli: un data center da un gigawatt costa 50 miliardi di dollari, Spectrum-X migliora la produttività del 25%, equivalendo a un risparmio di 5 miliardi di dollari. “Si può dire che questo sistema di rete è quasi ‘gratis’.” In tema sicurezza, Vera Rubin supporta anche il Confidential Computing. Tutti i dati sono cifrati in ogni fase di trasporto, archiviazione ed elaborazione, inclusi i bus PCIe, NVLink, comunicazione CPU-GPU e tutte le interconnessioni. Le aziende possono così implementare i loro modelli su sistemi esterni senza preoccuparsi di fughe di dati. DeepSeek ha sconvolto il mondo, open source e agenti sono la tendenza AI Terminata la parte principale, torniamo all’inizio del discorso. Appena salito sul palco, Jensen Huang ha lanciato un dato impressionante: circa 10 trilioni di dollari di risorse di calcolo investite nell’ultimo decennio stanno subendo una completa modernizzazione. Ma non si tratta solo di un aggiornamento hardware, bensì di un cambio di paradigma software. Ha menzionato in particolare i modelli di agenti dotati di capacità comportamentali autonome, citando Cursor, che ha rivoluzionato il modo di programmare interno a Nvidia.

L’anno scorso Nvidia ha presentato l’architettura Grace-Blackwell per espandere la memoria, ma non bastava ancora. La soluzione Vera Rubin prevede invece l’installazione di processori BlueField-4 nel rack, dedicati alla gestione della KV Cache. Ogni nodo ha 4 BlueField-4, ognuno con 150TB di memoria di contesto, che viene distribuita alle GPU. Ogni GPU ottiene così ulteriori 16TB di memoria, mentre la memoria nativa della GPU è circa 1TB. E soprattutto, la banda rimane a 200Gbps, senza perdita di velocità. Ma non basta solo la capacità: per far sì che i “post-it” distribuiti su decine di rack e migliaia di GPU lavorino come un’unica memoria, la rete deve essere “abbastanza grande, veloce e stabile”. Qui entra in gioco Spectrum-X. Spectrum-X è la prima piattaforma Ethernet end-to-end “progettata per l’AI generativa” a livello mondiale, realizzata da Nvidia. L’ultima generazione di Spectrum-X usa il processo COOP di TSMC, integra la silicon photonics, con 512 canali a 200Gbps ciascuno. Jensen Huang ha fatto due calcoli: un data center da un gigawatt costa 50 miliardi di dollari, Spectrum-X migliora la produttività del 25%, equivalendo a un risparmio di 5 miliardi di dollari. “Si può dire che questo sistema di rete è quasi ‘gratis’.” In tema sicurezza, Vera Rubin supporta anche il Confidential Computing. Tutti i dati sono cifrati in ogni fase di trasporto, archiviazione ed elaborazione, inclusi i bus PCIe, NVLink, comunicazione CPU-GPU e tutte le interconnessioni. Le aziende possono così implementare i loro modelli su sistemi esterni senza preoccuparsi di fughe di dati. DeepSeek ha sconvolto il mondo, open source e agenti sono la tendenza AI Terminata la parte principale, torniamo all’inizio del discorso. Appena salito sul palco, Jensen Huang ha lanciato un dato impressionante: circa 10 trilioni di dollari di risorse di calcolo investite nell’ultimo decennio stanno subendo una completa modernizzazione. Ma non si tratta solo di un aggiornamento hardware, bensì di un cambio di paradigma software. Ha menzionato in particolare i modelli di agenti dotati di capacità comportamentali autonome, citando Cursor, che ha rivoluzionato il modo di programmare interno a Nvidia.  Ciò che ha infiammato la platea è stata la sua valutazione estremamente positiva della comunità open source. Jensen Huang ha dichiarato che il breakthrough di DeepSeek V1 dell’anno scorso ha sorpreso il mondo intero: come primo sistema open source di inferenza, ha dato il via a un’ondata di sviluppo in tutto il settore. Nella slide, i player cinesi Kimi k2 e DeepSeek V3.2 sono rispettivamente primo e secondo tra i modelli open source. Secondo Jensen Huang, sebbene i modelli open source oggi siano forse indietro di circa sei mesi rispetto ai top di gamma, ogni sei mesi ne emerge uno nuovo. Questa velocità di iterazione è irresistibile per startup, colossi e ricercatori, inclusa Nvidia stessa. Così, questa volta non si sono limitati a vendere pale o schede grafiche; Nvidia ha costruito il supercomputer DGX Cloud dal valore di miliardi di dollari e sviluppato modelli d’avanguardia come La Proteina (sintesi proteica) e OpenFold 3.

Ciò che ha infiammato la platea è stata la sua valutazione estremamente positiva della comunità open source. Jensen Huang ha dichiarato che il breakthrough di DeepSeek V1 dell’anno scorso ha sorpreso il mondo intero: come primo sistema open source di inferenza, ha dato il via a un’ondata di sviluppo in tutto il settore. Nella slide, i player cinesi Kimi k2 e DeepSeek V3.2 sono rispettivamente primo e secondo tra i modelli open source. Secondo Jensen Huang, sebbene i modelli open source oggi siano forse indietro di circa sei mesi rispetto ai top di gamma, ogni sei mesi ne emerge uno nuovo. Questa velocità di iterazione è irresistibile per startup, colossi e ricercatori, inclusa Nvidia stessa. Così, questa volta non si sono limitati a vendere pale o schede grafiche; Nvidia ha costruito il supercomputer DGX Cloud dal valore di miliardi di dollari e sviluppato modelli d’avanguardia come La Proteina (sintesi proteica) e OpenFold 3.  L’ecosistema dei modelli open source Nvidia copre biomedicina, AI fisica, agenti, robotica e guida autonoma La famiglia di modelli open source Nvidia Nemotron è stata un altro punto forte del discorso. Include modelli per voce, multimodali, retrieval generativo aumentato e sicurezza. Huang ha anche sottolineato che i modelli open source Nemotron si sono distinti in numerose classifiche di test e sono ampiamente adottati dalle aziende. Cos’è l’AI fisica? Decine di modelli lanciati in un solo colpo Se i grandi modelli linguistici risolvono i problemi del “mondo digitale”, l’ambizione successiva di Nvidia è chiaramente quella di conquistare il “mondo fisico”. Huang ha sottolineato che per permettere all’AI di comprendere le leggi fisiche e vivere nel mondo reale servono dati estremamente rari. Oltre ai modelli open source di agenti Nemotron, ha proposto l’architettura core delle “tre tipologie di computer” per costruire l’AI fisica (Physical AI).

L’ecosistema dei modelli open source Nvidia copre biomedicina, AI fisica, agenti, robotica e guida autonoma La famiglia di modelli open source Nvidia Nemotron è stata un altro punto forte del discorso. Include modelli per voce, multimodali, retrieval generativo aumentato e sicurezza. Huang ha anche sottolineato che i modelli open source Nemotron si sono distinti in numerose classifiche di test e sono ampiamente adottati dalle aziende. Cos’è l’AI fisica? Decine di modelli lanciati in un solo colpo Se i grandi modelli linguistici risolvono i problemi del “mondo digitale”, l’ambizione successiva di Nvidia è chiaramente quella di conquistare il “mondo fisico”. Huang ha sottolineato che per permettere all’AI di comprendere le leggi fisiche e vivere nel mondo reale servono dati estremamente rari. Oltre ai modelli open source di agenti Nemotron, ha proposto l’architettura core delle “tre tipologie di computer” per costruire l’AI fisica (Physical AI).

Computer di addestramento, cioè quelli costruiti con GPU di classe training, come l’architettura GB300 citata nell’immagine.

Computer di inferenza, ovvero il “cervelletto” che lavora su robot o veicoli edge, responsabile dell’esecuzione in tempo reale.

Computer di simulazione, tra cui Omniverse e Cosmos, che forniscono ambienti virtuali di training per AI, consentendole di apprendere feedback fisici tramite la simulazione.

Il sistema Cosmos può generare numerosi ambienti di training AI per il mondo fisico Sulla base di questa architettura, Jensen Huang ha presentato ufficialmente Alpamayo, il primo modello di guida autonoma al mondo dotato di capacità di ragionamento e pensiero.

Il sistema Cosmos può generare numerosi ambienti di training AI per il mondo fisico Sulla base di questa architettura, Jensen Huang ha presentato ufficialmente Alpamayo, il primo modello di guida autonoma al mondo dotato di capacità di ragionamento e pensiero.  A differenza dei sistemi tradizionali, Alpamayo è un sistema end-to-end. La sua innovazione risiede nella soluzione del “problema della coda lunga” della guida autonoma. Di fronte a situazioni stradali mai viste prima, Alpamayo non esegue più solo codice in modo meccanico, ma può ragionare come un guidatore umano. “Ti dice cosa farà dopo, e perché prenderà quella decisione.” Durante la demo, lo stile di guida era sorprendentemente naturale, capace di scomporre scenari estremamente complessi in elementi di buon senso. Oltre alla demo, tutto ciò non è solo teoria. Jensen Huang ha annunciato che la Mercedes CLA con la tecnologia Alpamayo sarà lanciata negli Stati Uniti nel primo trimestre di quest’anno, e a seguire gradualmente in Europa e Asia.

A differenza dei sistemi tradizionali, Alpamayo è un sistema end-to-end. La sua innovazione risiede nella soluzione del “problema della coda lunga” della guida autonoma. Di fronte a situazioni stradali mai viste prima, Alpamayo non esegue più solo codice in modo meccanico, ma può ragionare come un guidatore umano. “Ti dice cosa farà dopo, e perché prenderà quella decisione.” Durante la demo, lo stile di guida era sorprendentemente naturale, capace di scomporre scenari estremamente complessi in elementi di buon senso. Oltre alla demo, tutto ciò non è solo teoria. Jensen Huang ha annunciato che la Mercedes CLA con la tecnologia Alpamayo sarà lanciata negli Stati Uniti nel primo trimestre di quest’anno, e a seguire gradualmente in Europa e Asia.  Questa vettura è stata valutata da NCAP come la più sicura al mondo, grazie al design Nvidia con “doppio stack di sicurezza”: quando il modello AI end-to-end ha poca fiducia nella situazione stradale, il sistema torna immediatamente a una modalità di sicurezza tradizionale più affidabile, garantendo la sicurezza assoluta. Alla conferenza, Jensen Huang ha anche mostrato la strategia robotica di Nvidia.

Questa vettura è stata valutata da NCAP come la più sicura al mondo, grazie al design Nvidia con “doppio stack di sicurezza”: quando il modello AI end-to-end ha poca fiducia nella situazione stradale, il sistema torna immediatamente a una modalità di sicurezza tradizionale più affidabile, garantendo la sicurezza assoluta. Alla conferenza, Jensen Huang ha anche mostrato la strategia robotica di Nvidia.  La competizione tra le nove principali aziende AI e hardware: tutte stanno ampliando la gamma prodotti, puntando in particolare al settore robotico. Le celle evidenziate rappresentano i nuovi prodotti dal 2023 a oggi. Tutti i robot avranno computer Jetson, saranno addestrati nel simulatore Isaac di Omniverse, e Nvidia sta integrando questa tecnologia nei sistemi industriali di Synopsys, Cadence, Siemens e altri.

La competizione tra le nove principali aziende AI e hardware: tutte stanno ampliando la gamma prodotti, puntando in particolare al settore robotico. Le celle evidenziate rappresentano i nuovi prodotti dal 2023 a oggi. Tutti i robot avranno computer Jetson, saranno addestrati nel simulatore Isaac di Omniverse, e Nvidia sta integrando questa tecnologia nei sistemi industriali di Synopsys, Cadence, Siemens e altri.  Jensen Huang ha invitato sul palco robot umanoidi e quadrupedi di aziende come Boston Dynamics e Agility, sottolineando che il più grande robot è in realtà la fabbrica stessa. Dal basso verso l’alto, la visione Nvidia è che in futuro la progettazione di chip, sistemi e la simulazione di fabbrica saranno tutte accelerate dall’AI fisica Nvidia. Alla presentazione, è stato protagonista anche un robot Disney; Huang ha scherzato con questi adorabili robot: “Sarete progettati al computer, costruiti al computer e persino testati e validati al computer prima di affrontare la gravità reale.”

Jensen Huang ha invitato sul palco robot umanoidi e quadrupedi di aziende come Boston Dynamics e Agility, sottolineando che il più grande robot è in realtà la fabbrica stessa. Dal basso verso l’alto, la visione Nvidia è che in futuro la progettazione di chip, sistemi e la simulazione di fabbrica saranno tutte accelerate dall’AI fisica Nvidia. Alla presentazione, è stato protagonista anche un robot Disney; Huang ha scherzato con questi adorabili robot: “Sarete progettati al computer, costruiti al computer e persino testati e validati al computer prima di affrontare la gravità reale.”  Se non fosse Jensen Huang, si potrebbe quasi pensare che questa sia stata la conferenza di un’azienda di modelli AI. Oggi, con lo scetticismo sulla presunta “bolla AI” sempre più diffuso, oltre al rallentamento della legge di Moore, Jensen Huang sembra voler rafforzare la nostra fiducia nell’AI mostrando cosa può davvero fare. Oltre a presentare la potente piattaforma di supercalcolo AI Vera Rubin per calmare la sete di potenza, ha dedicato più impegno che mai alle applicazioni e al software, facendo tutto il possibile per mostrarci quali cambiamenti tangibili porterà l’AI. Inoltre, come ha detto Jensen Huang, se in passato costruivano chip per il mondo virtuale, ora si mettono in gioco direttamente, concentrandosi su AI fisica come guida autonoma e robot umanoidi, entrando nel mondo fisico reale dove la competizione è più agguerrita. Dopotutto, solo quando la guerra è in corso si possono continuare a vendere armi. *Infine, ecco il video bonus: a causa del tempo limitato per il discorso al CES, Jensen Huang non ha potuto presentare molte slide. Così ha deciso di realizzare un divertente video con le slide non mostrate. Godetevelo⬇️

Se non fosse Jensen Huang, si potrebbe quasi pensare che questa sia stata la conferenza di un’azienda di modelli AI. Oggi, con lo scetticismo sulla presunta “bolla AI” sempre più diffuso, oltre al rallentamento della legge di Moore, Jensen Huang sembra voler rafforzare la nostra fiducia nell’AI mostrando cosa può davvero fare. Oltre a presentare la potente piattaforma di supercalcolo AI Vera Rubin per calmare la sete di potenza, ha dedicato più impegno che mai alle applicazioni e al software, facendo tutto il possibile per mostrarci quali cambiamenti tangibili porterà l’AI. Inoltre, come ha detto Jensen Huang, se in passato costruivano chip per il mondo virtuale, ora si mettono in gioco direttamente, concentrandosi su AI fisica come guida autonoma e robot umanoidi, entrando nel mondo fisico reale dove la competizione è più agguerrita. Dopotutto, solo quando la guerra è in corso si possono continuare a vendere armi. *Infine, ecco il video bonus: a causa del tempo limitato per il discorso al CES, Jensen Huang non ha potuto presentare molte slide. Così ha deciso di realizzare un divertente video con le slide non mostrate. Godetevelo⬇️

0

0

Esclusione di responsabilità: il contenuto di questo articolo riflette esclusivamente l’opinione dell’autore e non rappresenta in alcun modo la piattaforma. Questo articolo non deve essere utilizzato come riferimento per prendere decisioni di investimento.

PoolX: Blocca per guadagnare

Almeno il 12% di APR. Sempre disponibile, ottieni sempre un airdrop.

Blocca ora!

Ti potrebbe interessare anche

Le notizie dal Venezuela aggiungono ulteriore pressione sui prezzi del petrolio – ING

101 finance•2026/01/08 09:36

Il traffico di ChatGPT si è fermato, mentre Gemini di Google è in forte crescita

硬AI•2026/01/08 08:47

EUR/USD si stabilizza dopo i cali mentre l'attenzione si sposta sui dati economici dell'Eurozona

101 finance•2026/01/08 08:43

In tendenza

AltroPrezzi delle criptovalute

AltroBitcoin

BTC

$89,898.09

-2.16%

Ethereum

ETH

$3,102.82

-3.77%

Tether USDt

USDT

$0.9988

-0.04%

XRP

XRP

$2.1

-6.79%

BNB

BNB

$880.45

-3.65%

Solana

SOL

$134.42

-2.47%

USDC

USDC

$0.9995

-0.02%

TRON

TRX

$0.2952

+0.08%

Dogecoin

DOGE

$0.1427

-5.00%

Cardano

ADA

$0.3907

-5.50%

Come vendere PI

Bitget lista PI – Acquista o vendi PI rapidamente su Bitget!

Fai trading

Non sei ancora un Bitgetter?Un pacchetto di benvenuto del valore di 6.200 USDT per i nuovi utenti!

Iscriviti ora